|

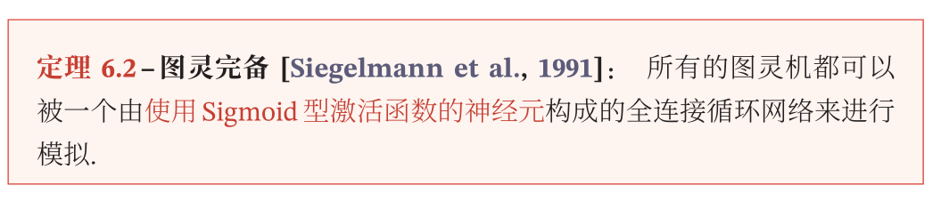

给定一个输入信号序列

|

|

|

|

|

|

|

|

卷积扩展

|

|

|

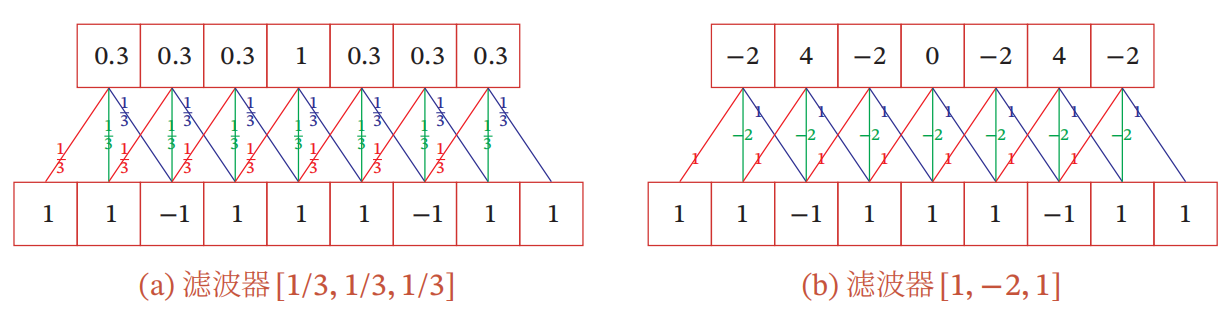

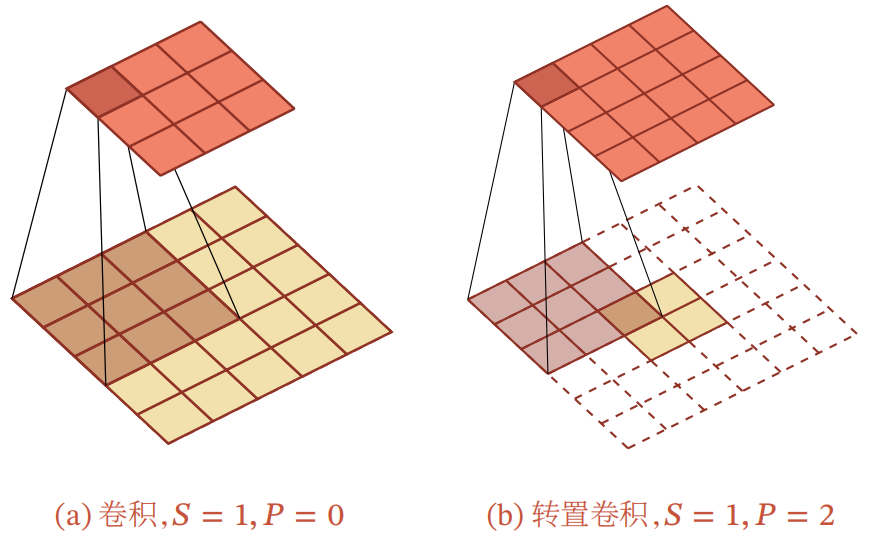

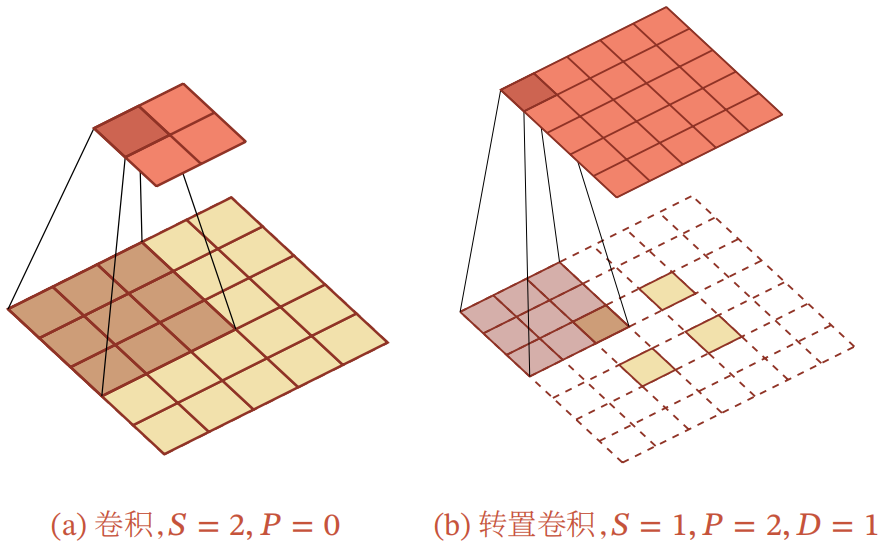

步长(Stride) 是指卷积核在滑动时的时间间隔.图(a)给出了步长为2的卷积示例. |

零填充(Zero Padding) 是在输入向量两端进行补零.图(b)给出了输入的两端各补一个零后的卷积示例. |

卷积类型

-

卷积的结果按输出长度不同可以分为三类:

- 窄卷积:步长

- 宽卷积:步长

- 等宽卷积:步长

- 窄卷积:步长

-

在早期的文献中,卷积一般默认为窄卷积。

-

而目前的文献中,卷积一般默认为等宽卷积。

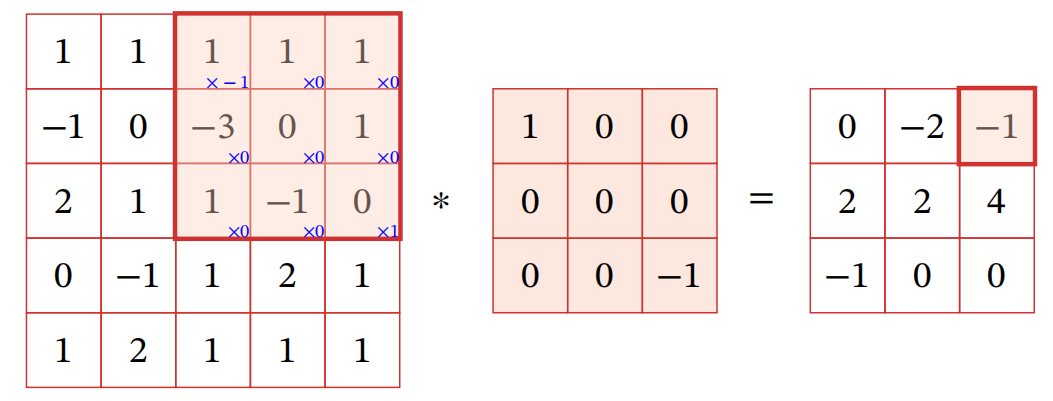

二维卷积

|

|

|

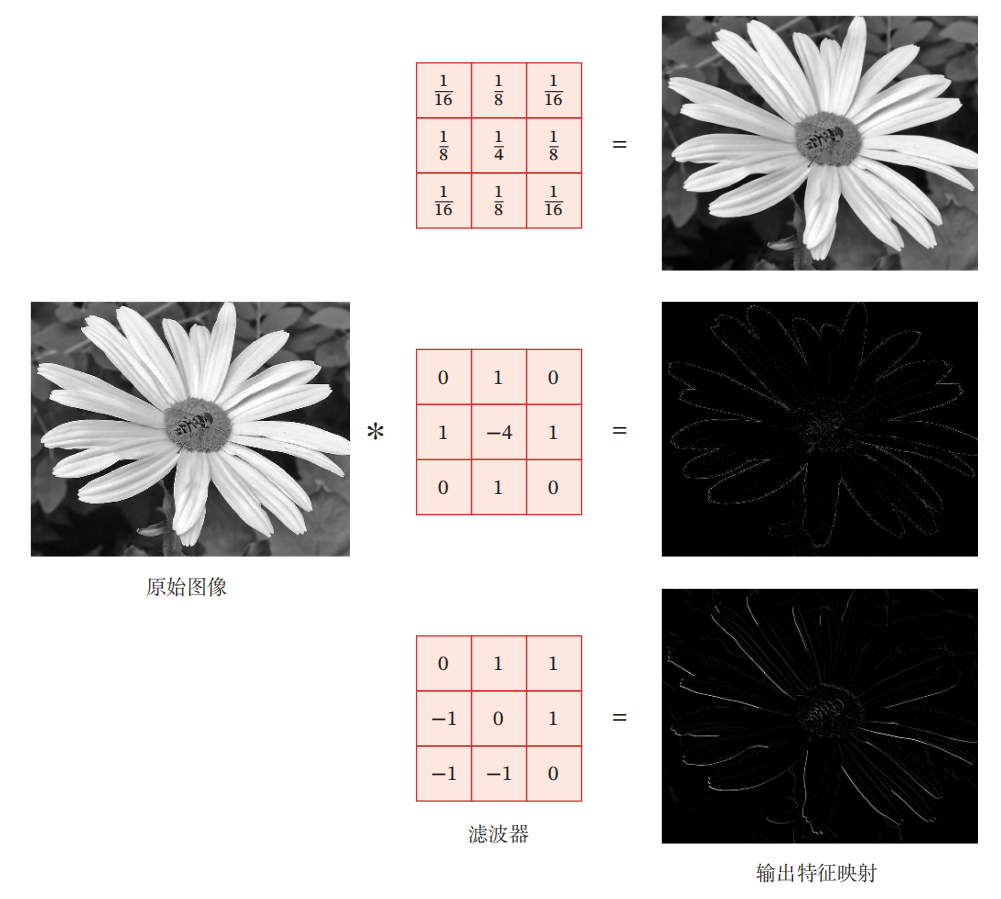

卷积作为特征提取器 |

互相关 |

|

|

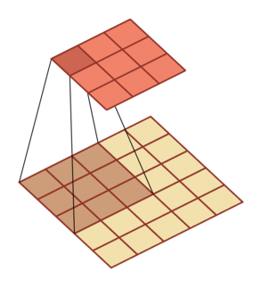

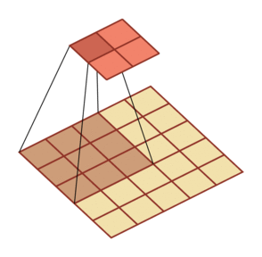

二维卷积的扩展

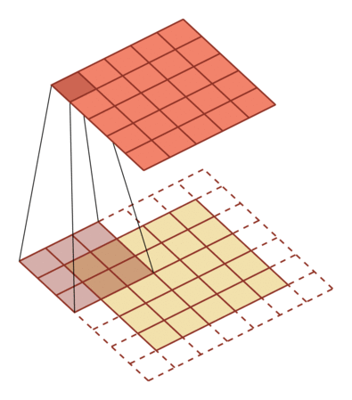

步长1,零填充0 |

步长2,零填充0 |

步长1,零填充1 |

步长2,零填充1 |

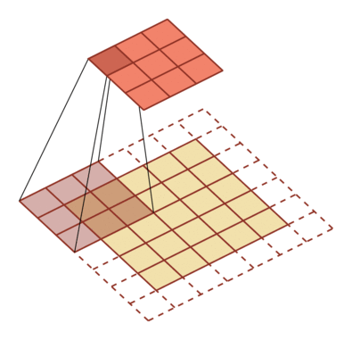

卷积神经网络 = 卷积层+汇聚层+全连接层

|

|

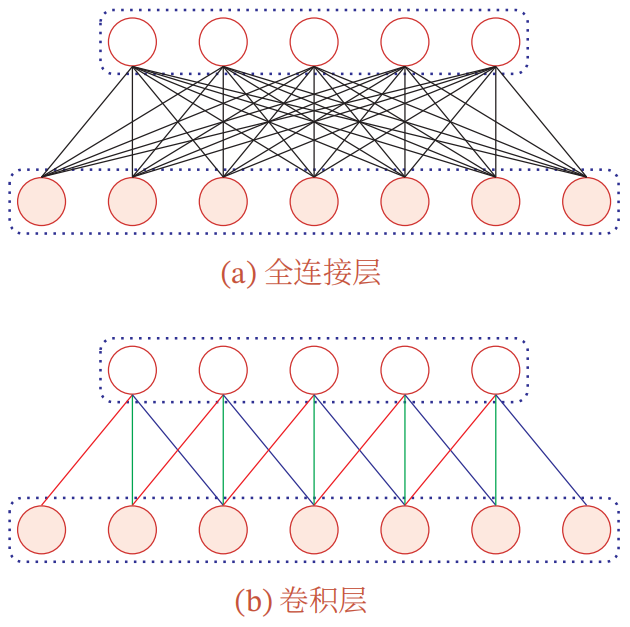

卷积层的典型结构

|

|

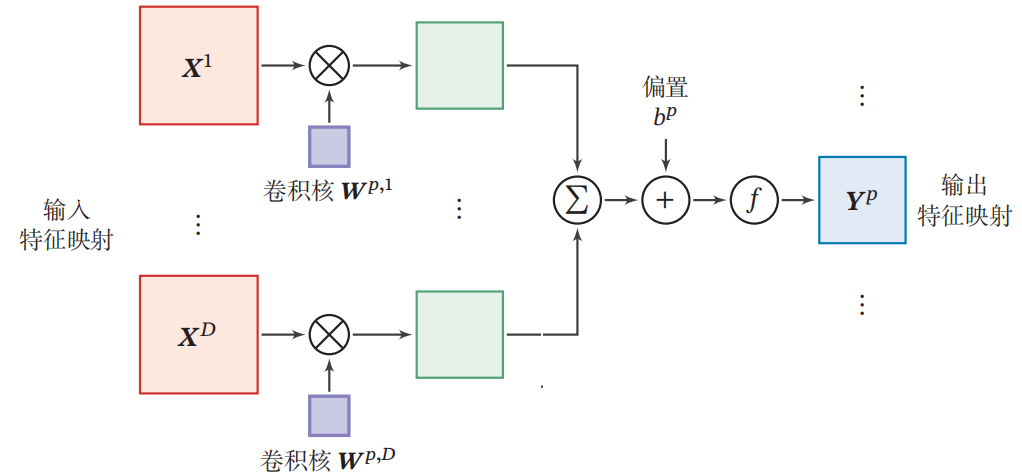

卷积层的映射关系

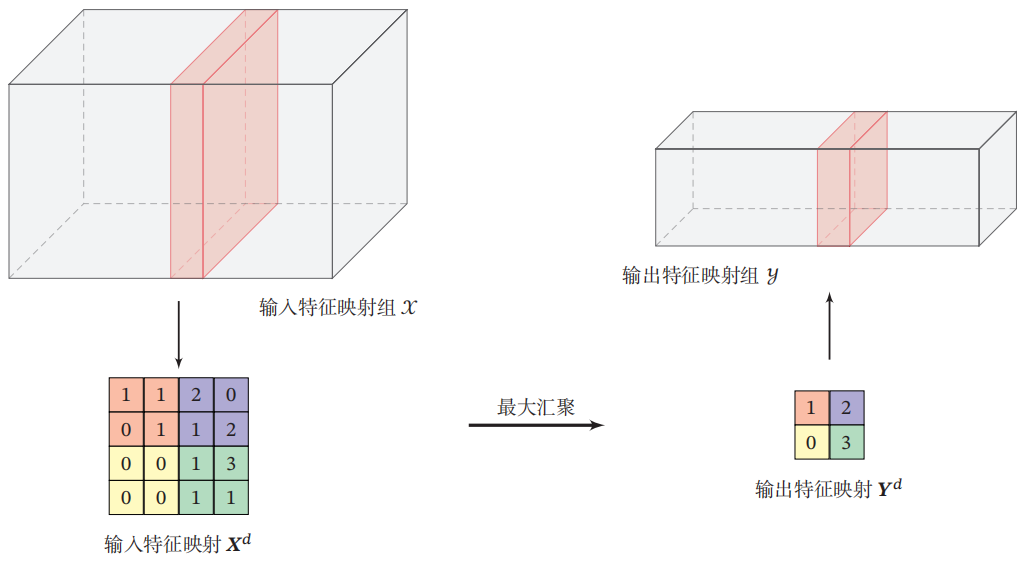

汇聚层

|

|

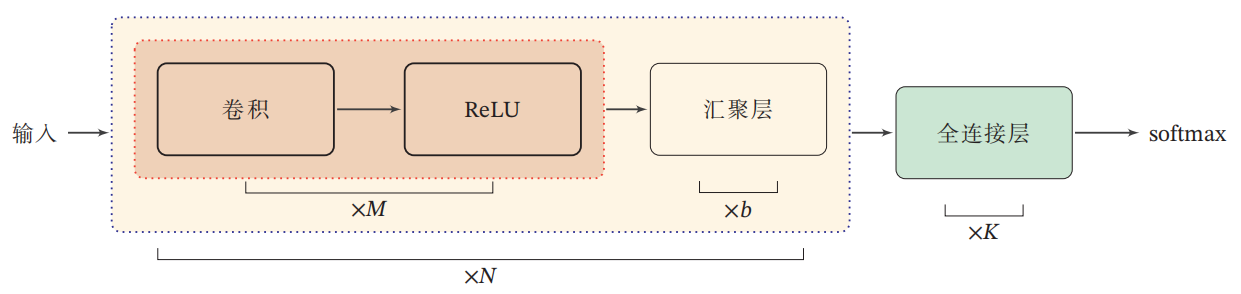

卷积网络结构

- 卷积网络是由卷积层、汇聚层、全连接层交叉堆叠而成。

- 趋向于小卷积、大深度

- 趋向于全卷积

- 典型结构

- 一个卷积块为连续

- 一个卷积块为连续

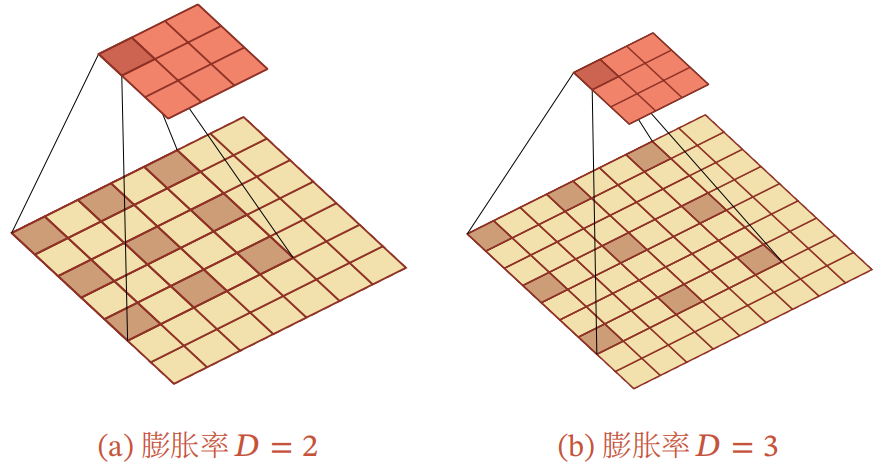

其它卷积种类

|

|

|

|

|

|

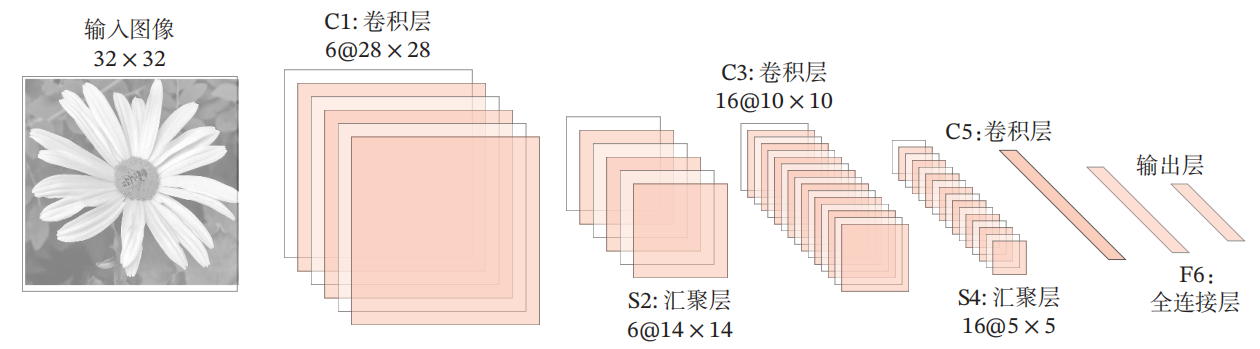

典型的卷积网络:LeNet-5

- LeNet-5 是一个非常成功的神经网络模型。

- 基于 LeNet-5 的手写数字识别系统在 90 年代被美国很多银行使用,用来识别支票上面的手写数字。

- LeNet-5 共有 7 层。

典型的卷积网络:AlexNet

- 2012 ILSVRC winner

(top 5 error of 16% compared to runner-up with 26% error)- 第一个现代深度卷积网络模型

- 首次使用了很多现代深度卷积网络的一些技术方法

- 使用GPU进行并行训练,采用了ReLU作为非线性激活函数,使用Dropout防止过拟合,使用数据增强

- 5个卷积层、3个汇聚层和3个全连接层

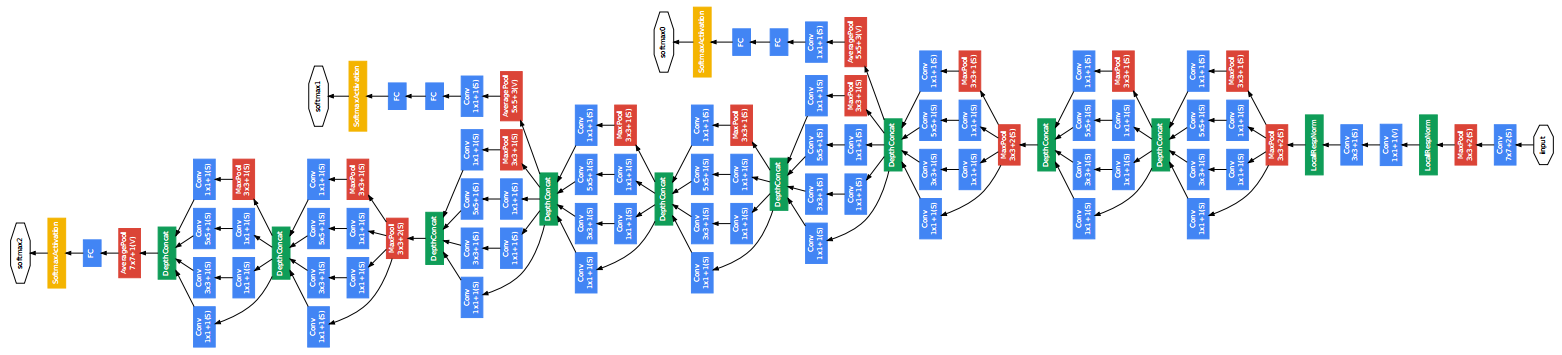

典型的卷积网络:Inception网络(GoogLeNet)

- 2014 ILSVRC winner (22层)

- 参数:GoogLeNet:4M VS AlexNet:60M

- 错误率:6.7%

- Inception网络是由有多个inception模块和少量的汇聚层堆叠而成。

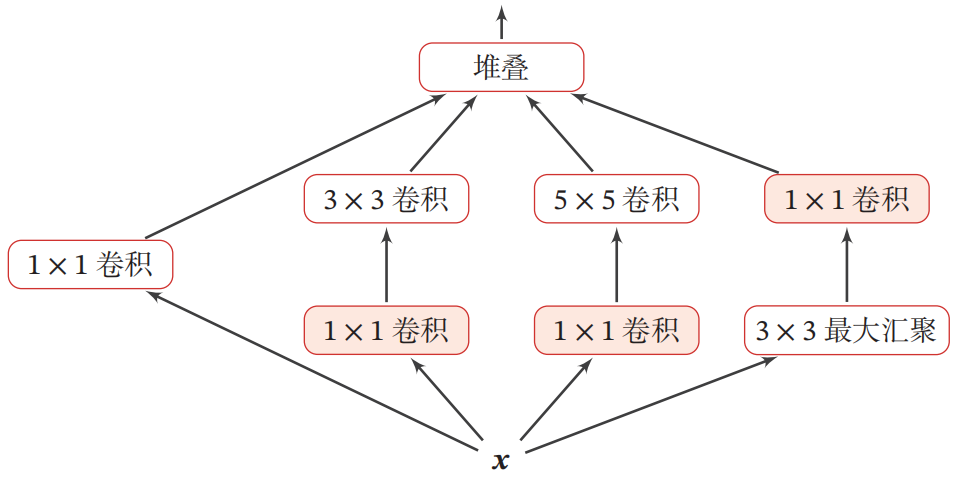

典型的卷积网络:Inception模块 v1

- 在卷积网络中,如何设置卷积层的卷积核大小是一个十分关键的问题。

- 在Inception网络中,一个卷积层包含多个不同大小的卷积操作,称为Inception模块。

- Inception模块同时使用

典型的卷积网络:Inception模块 v3

- 用多层小卷积核替换大卷积核,以减少计算量和参数量。

- 使用两层3x3的卷积来替换v1中的

- 使用连续的

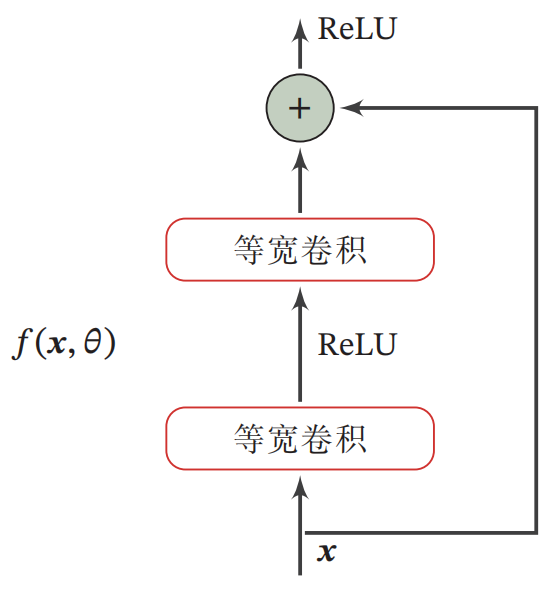

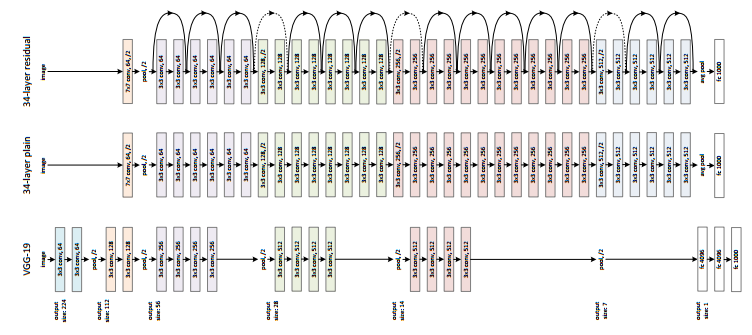

典型的卷积网络:残差网络

|

|

典型的卷积网络:ResNet

- 2015 ILSVRC winner (152层)

- 错误率:3.57%

循环神经网络(Recurrent Neural Networks, RNNs)

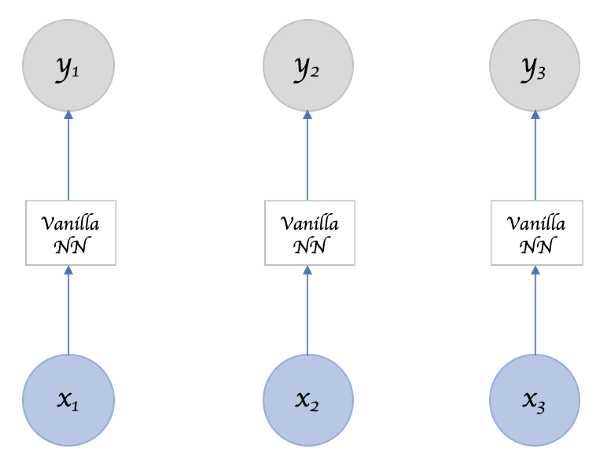

前馈网络

|

|

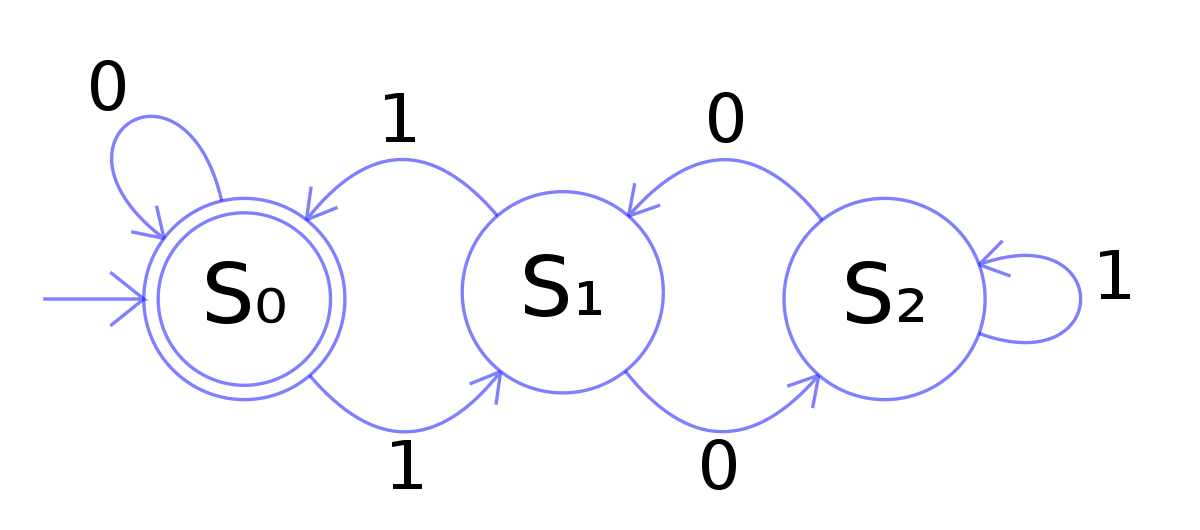

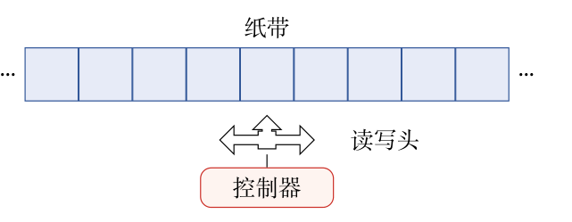

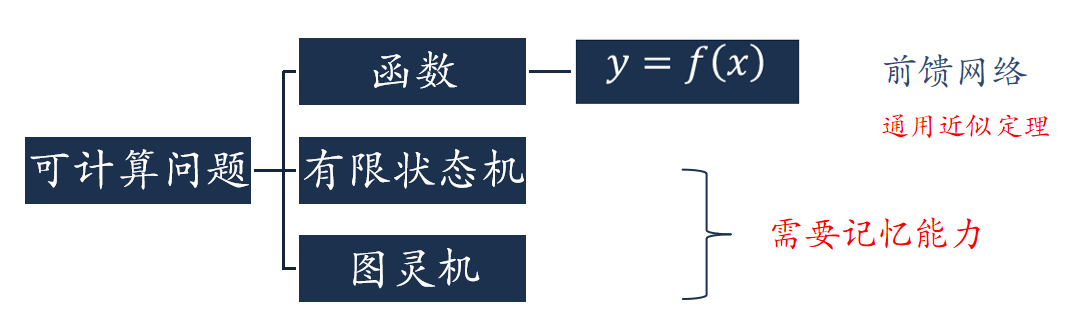

可计算问题

|

|

|

|

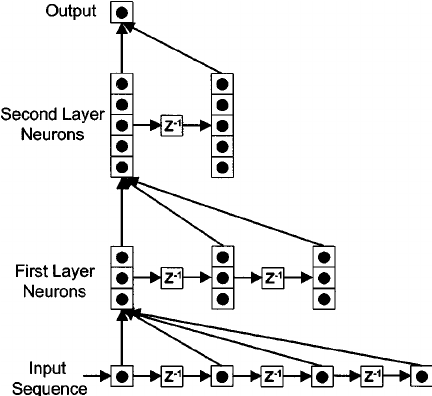

给网络增加记忆能力:延时神经网络(Time Delay Neural Network,TDNN)

|

|

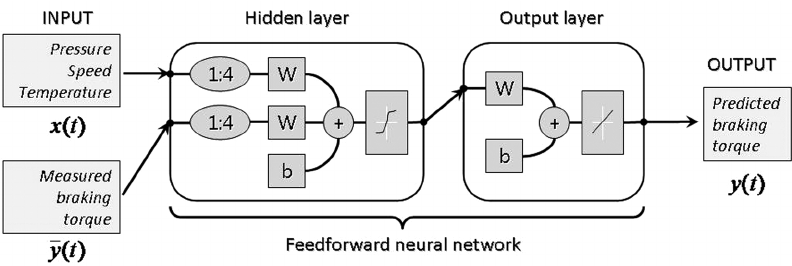

给网络增加记忆能力:自回归模型(Autoregressive Model,AR)

- 自回归模型:一类时间序列模型,用变量

- 有外部输入的非线性自回归模型(Nonlinear Autoregressive with Exogenous Inputs Model,NARX)

, - 其中

- 其中

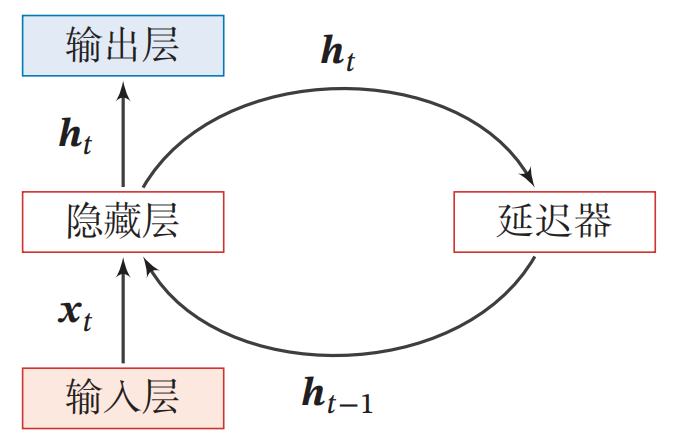

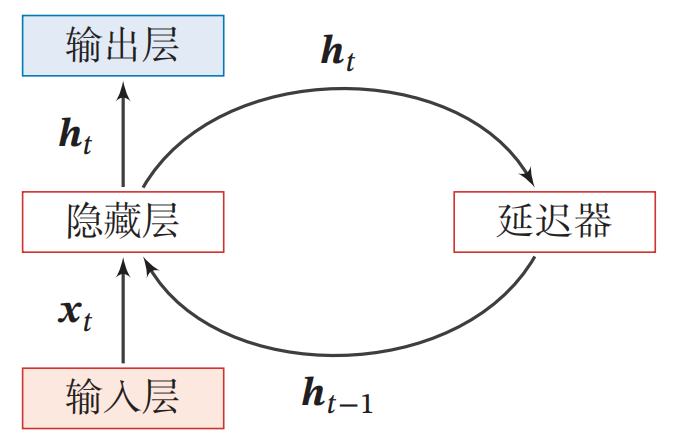

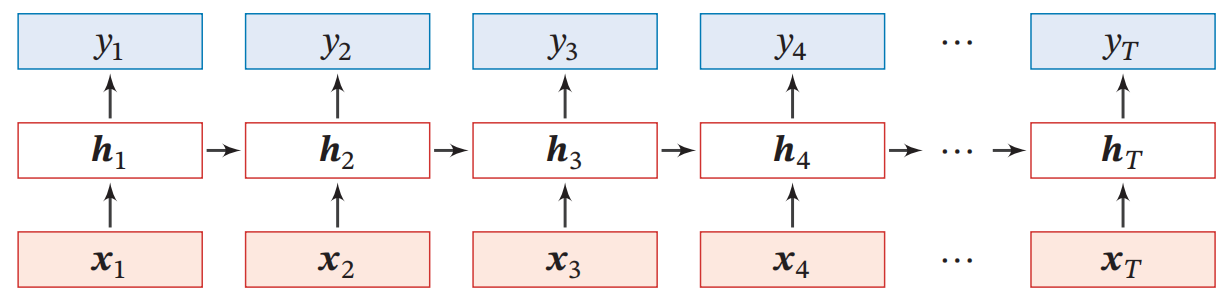

循环神经网络( Recurrent Neural Network ,RNN )

- 循环神经网络通过使用带自反馈的神经元,能够处理任意长度的时序数据。

|

|

|

- 循环神经网络比前馈神经网络更加符合生物神经网络的结构。

- 循环神经网络已经被广泛应用在语音识别、语言模型以及自然语言生成等任务上

- 作用:

- 输入-输出映射:机器学习模型

- 存储器:联想记忆模型

按时间展开

|

|

简单循环网络( Simple Recurrent Network , SRN )

|

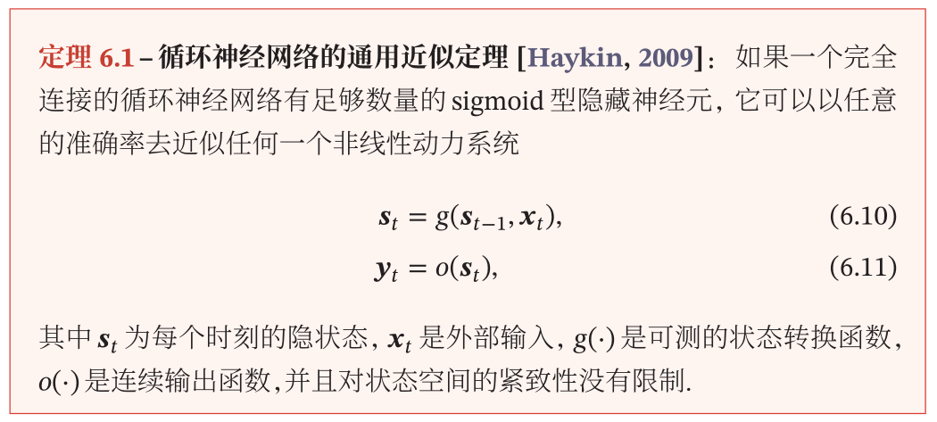

图灵完备

|

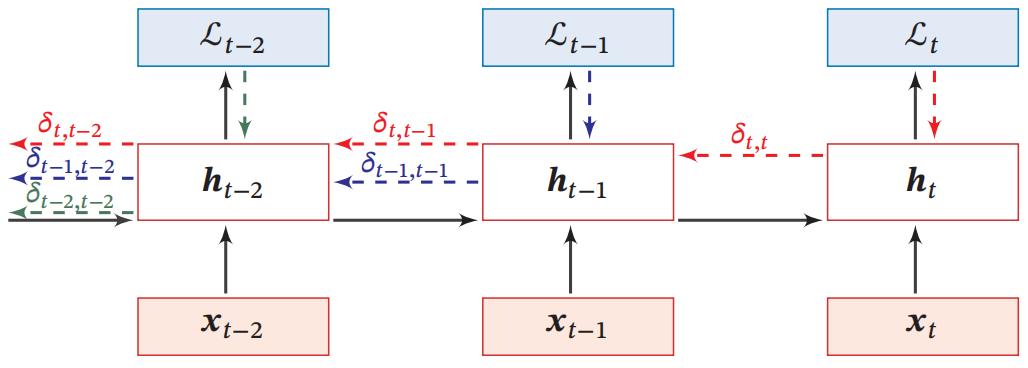

参数学习

|

随时间反向传播算法

|

梯度消失/爆炸与长程依赖

|

长程依赖问题的改进方法

|

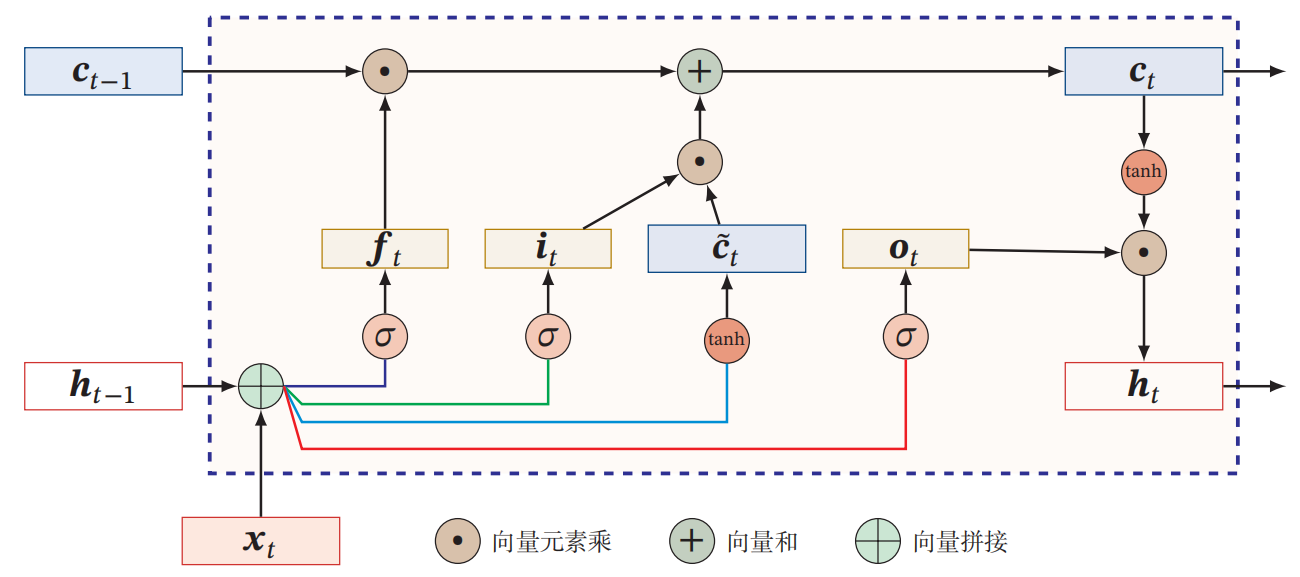

长短期记忆神经网络(Long Short-Term Memory, LSTM )

LSTM的各种变体

- 没有遗忘门

- 耦合输入门和遗忘门

- peephole连接

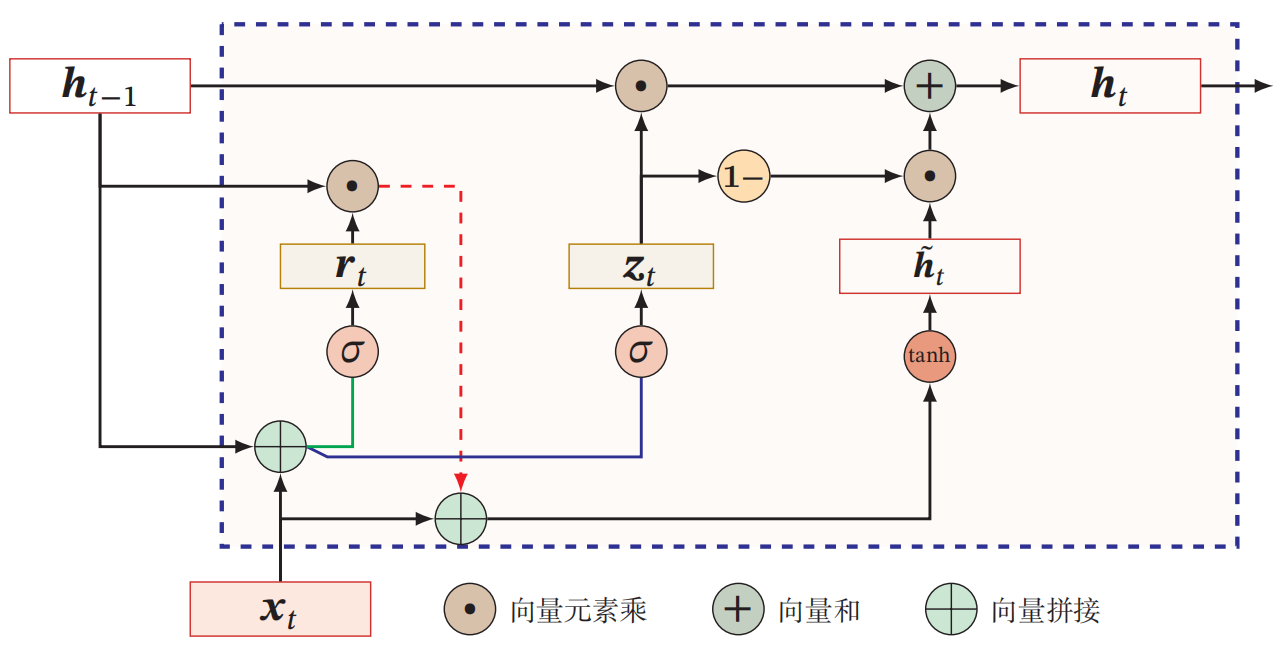

门控循环单元(Gated Recurrent Unit, GRU)

|

|

深层模型

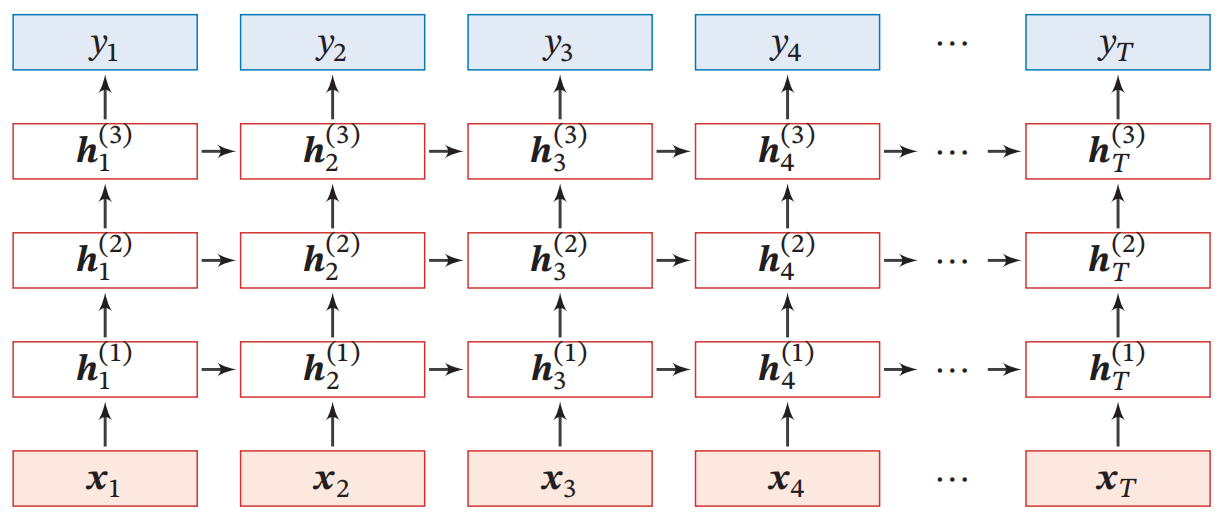

堆叠循环神经网络

|

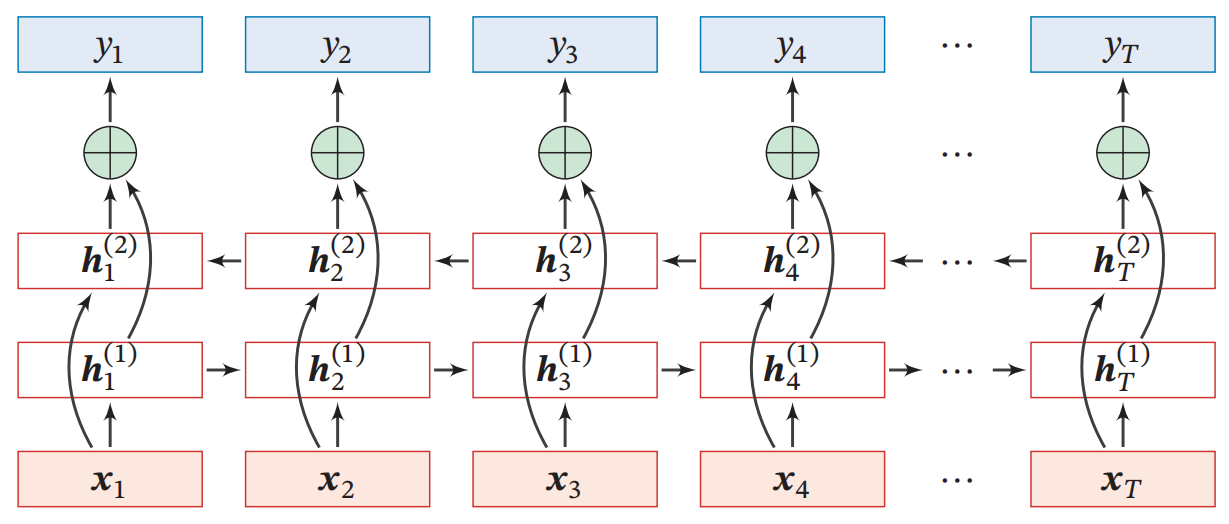

双向循环神经网络

|

|

|

循环网络应用

|

|

-

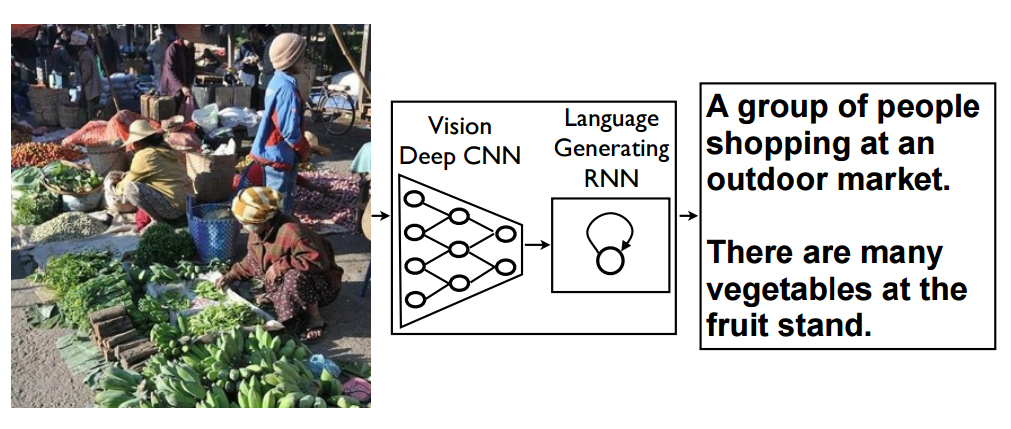

看图说话