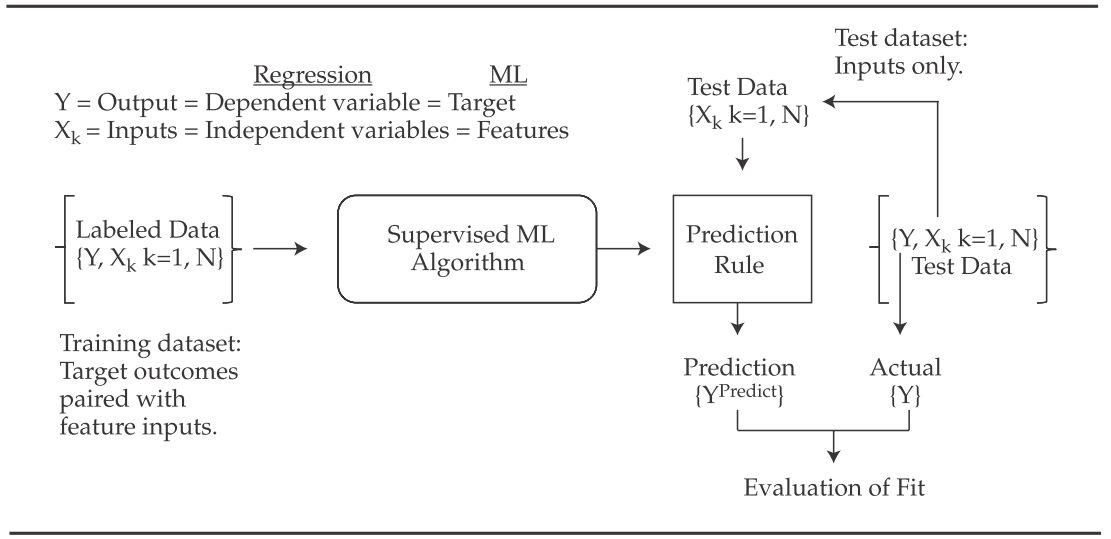

使用机器学习模型的一般流程

-

机器学习vs统计方法

- 统计方法依赖于基本假设和显式结构模型,例如假设从特定的概率分布中抽取的观察样本。

- 机器学习寻求从大量数据中提取知识,而没有这样的限制——“找到模式,应用模式。”

- 机器学习的优势:高维、非线性

-

监督学习vs无监督学习

- 监督学习算法通过标记数据集推断一组输入(

- 无监督学习是不使用标记数据的机器学习算法。 在无监督学习中,输入(

- 监督学习算法通过标记数据集推断一组输入(

-

深度学习vs强化学习

- 在深度学习中,复杂的算法可以解决高度复杂的任务,如图像分类、人脸识别、语音识别和自然语言处理。

- 强化学习,计算机通过与自身交互(或由相同算法生成的数据)来学习。

- 神经网络(NNs,也称为人工神经网络或 ANN)包括高度灵活的机器学习算法,这些算法已成功应用于各种以非线性和特征之间的交互为特征的任务。

- 除常用于分类和回归外,神经网络也是深度学习和强化学习的基础,可以是有监督的,也可以是无监督的。

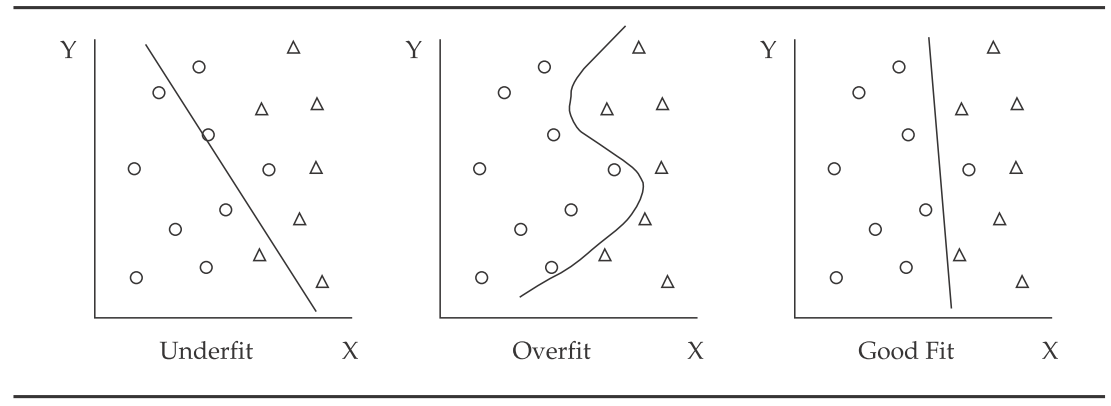

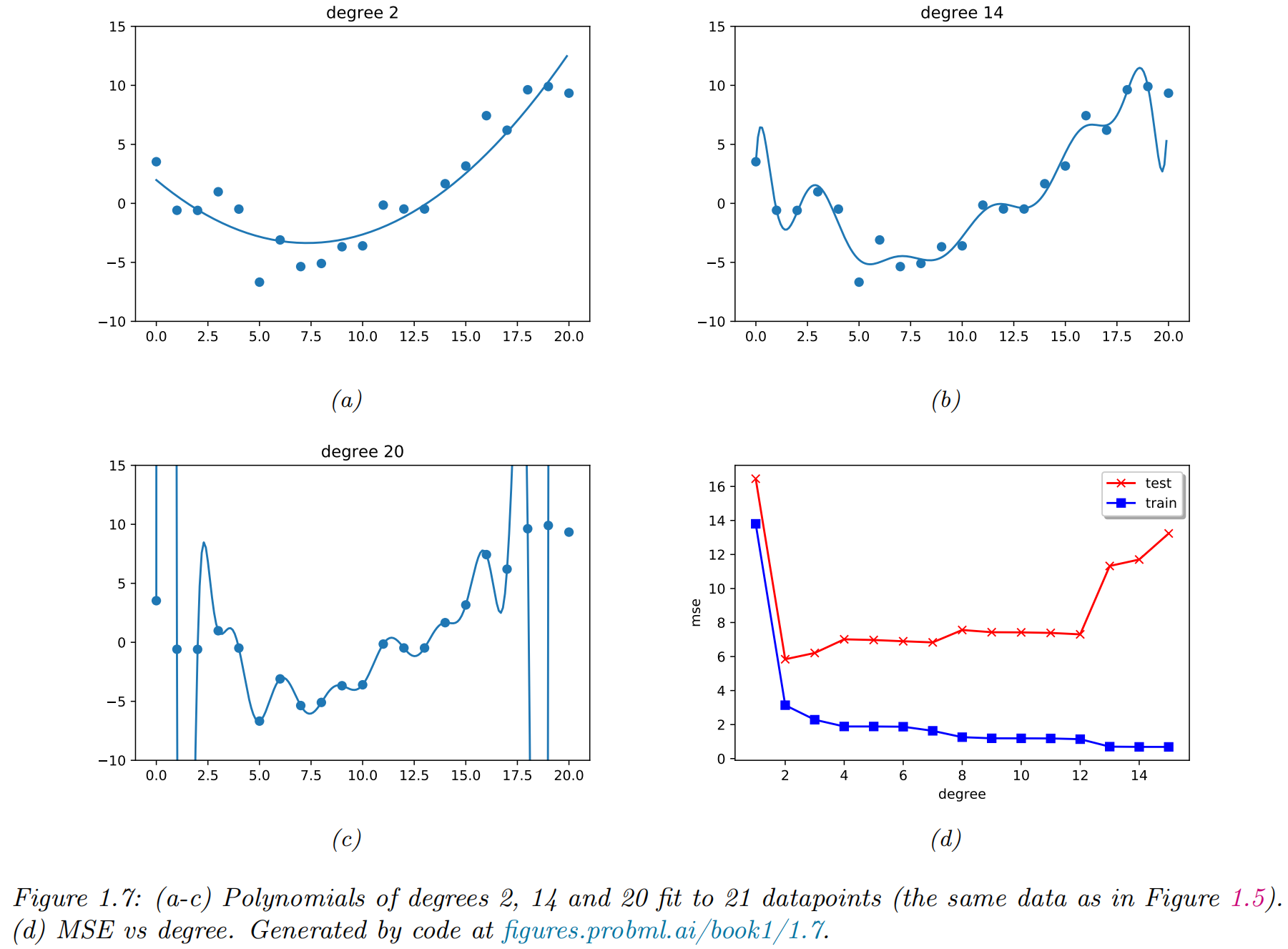

过拟合(Overfitting)和泛化(generalization)

- 欠拟合(Underfitting) 意味着模型未捕获数据中的关系。

- 过度拟合(Overfitting) 意味着模型开始纳入来自怪癖或虚假相关性的噪声

- 它将随机性误认为是模式和关系

- 记住数据,而不是从中学习

- 数据中的噪声水平较高且模型过于复杂

- 复杂性指模型特征、项或分支的数量,及模型是线性的还是非线性的(非线性更复杂)

- 经验风险(empirical risk)

- 总体风险(population risk)

-

泛化差距/泛化鸿沟(generalization gap):

-

测试风险(test risk)

评估 ML 算法性能错误和过度拟合

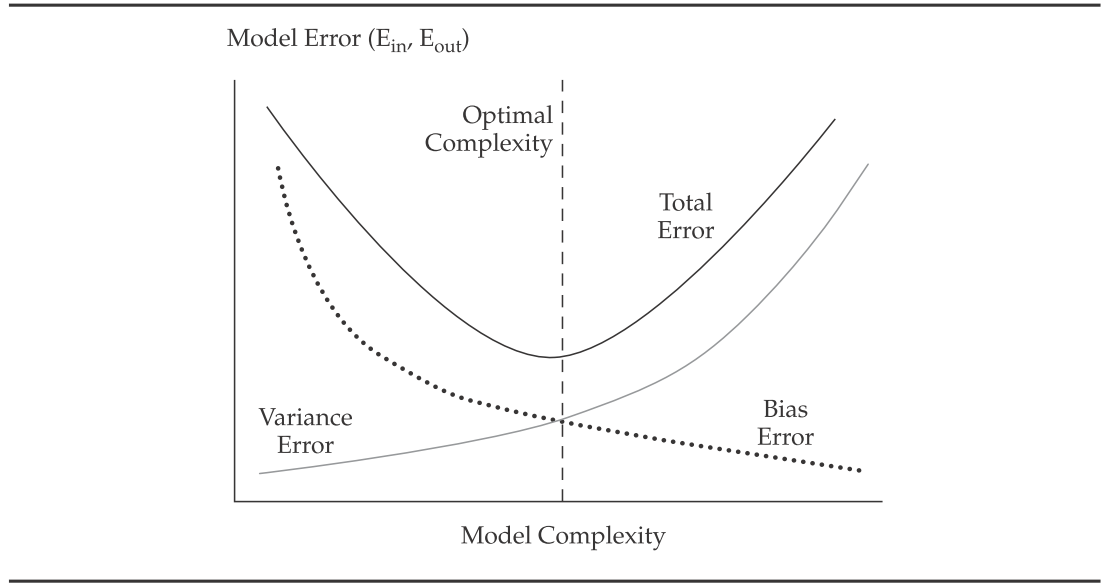

- 数据科学家将样本外总误差分解为三个来源:

- 偏差误差(Bias error),或模型与训练数据的拟合程度。 具有错误假设的算法会产生高偏差和较差的近似值,从而导致欠拟合和高样本内误差。

- 方差误差(Variance error),或者模型结果响应验证和测试样本中的新数据而变化的程度。 不稳定的模型会产生噪声并产生高方差,从而导致过度拟合

- 由于数据的随机性而导致的基本误差(Base error)。

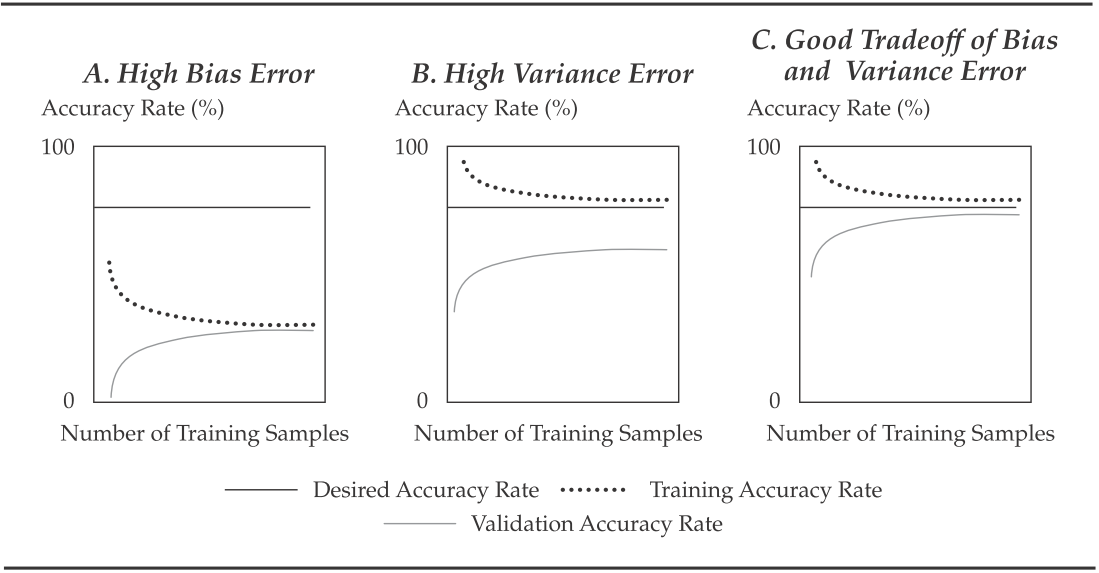

learning curve

- 学习曲线根据训练样本中的数据量绘制验证或测试样本(即样本外)的准确率(= 1 – 错误率)

拟合曲线

- 拟合曲线(fitting curve),显示针对模型绘制的

评估 ML 算法性能:防止监督学习中的过拟合

-

使用两个常见的指导原则和两种方法来减少过度拟合:

- 防止算法在选择和训练过程中变得过于复杂(正则化(regularization))

- 通过使用**交叉验证(cross-validation)**实现正确的数据采样

-

K折交叉验证(K-fold cross-validation)

- 数据(不包括测试样本和新鲜数据)随机打乱,然后分为k个相等的子样本

- 此过程重复

-

留一交叉验证(Leave-one-out cross-validation):

Cross-validation using sk-learn: train_test_split

|

|

((150, 4), (150,)) ((90, 4), (90,)) ((60, 4), (60,)) |

Cross-validation using sk-learn: computing cross-validated metrics

|

|

array([0.96..., 1. , 0.96..., 0.96..., 1. ]) 0.98 accuracy with a standard deviation of 0.02 array([0.96..., 1. ..., 0.96..., 0.96..., 1. ]) |

Time Series Split

|

|

TimeSeriesSplit(gap=0, max_train_size=None, n_splits=3, test_size=None) [0 1 2] [3] |

No free lunch theorem

All models are wrong, but some models are useful.

--- George Box

- 没有免费的午餐定理:没有一个最佳模型可以完美地解决所有类型的问题

- 选择合适的型号

- 基于领域知识

- 反复试验

- 交叉验证

- 贝叶斯模型选择技术

参考文献:Empirical Asset Pricing via Machine Learning

参考文献:Charting by Machines

参考文献:Financial Machine Learning

监督学习

- 任务

- 分类:

- 回归:

- 分类:

- 输入

- 输出

- 经验

统计推断与监督学习

| 性质 | 统计推断 | 监督机器学习 |

|---|---|---|

| 目标 | 具有解释力的因果模型 | 预测表现,往往解释力有限 |

| 数据 | 数据由模型生成 | 数据生成过程未知 |

| 框架 | 概率 | 算法和概率 |

| 表达能力 | 通常是线性的 | 非线性 |

| 模型选择 | 基于信息准则 | 数值优化 |

| 可扩展性 | 仅限于低维数据 | 缩放至高维输入数据 |

| 稳健性 | 容易出现过度拟合 | 专为样本外性能而设计 |

| 诊断 | 广泛 | 有限 |

回归(Regression)

|

|

- 示例

- 不确定性: Guassian / Normal

- 条件分布

- NLL

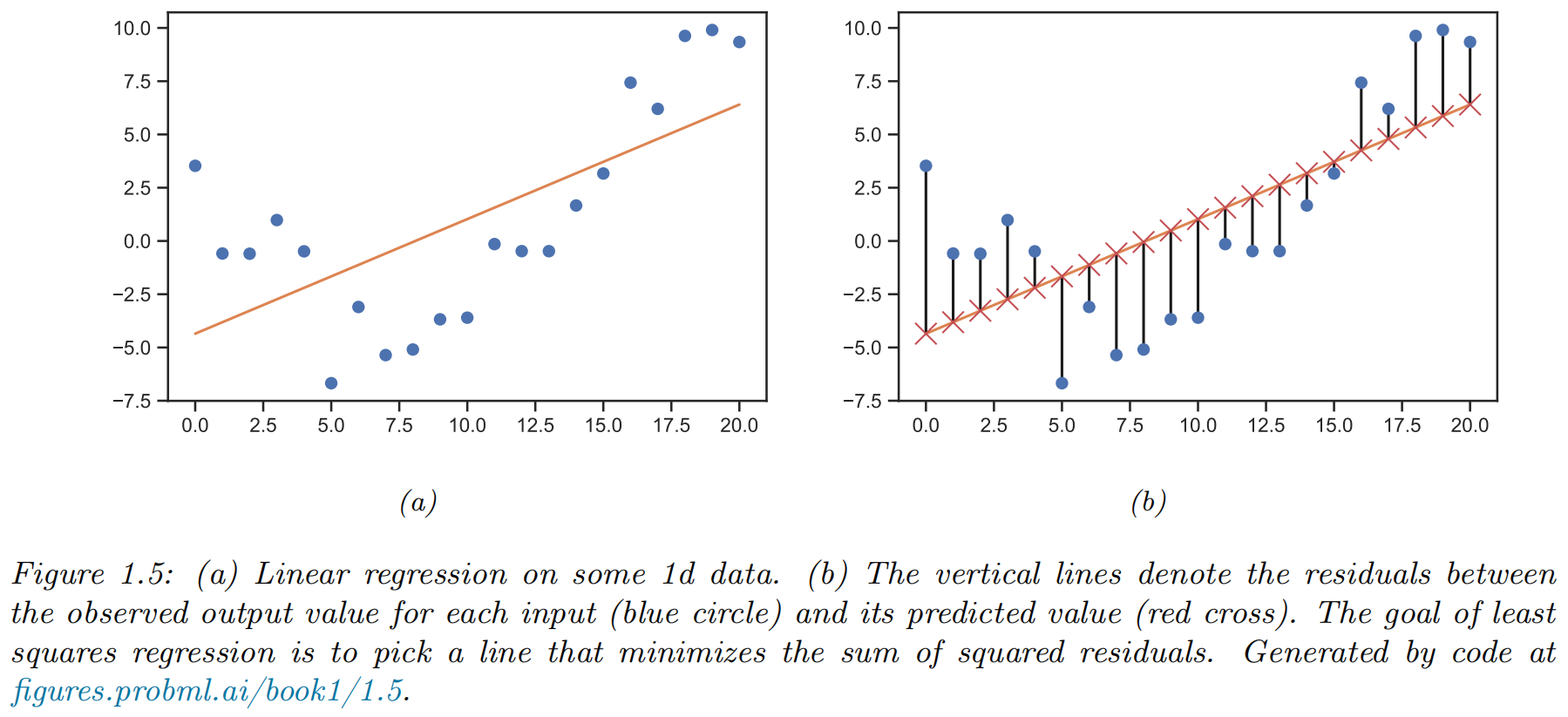

(简单) 线性回归

- 模型:

- 参数:

- 最小二乘估计:

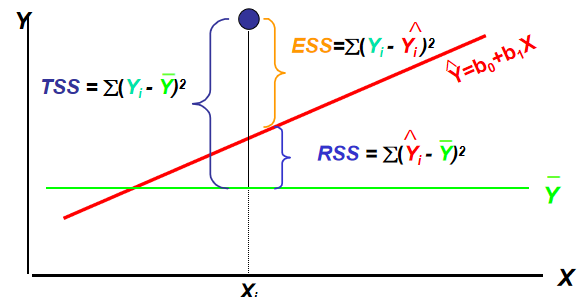

拟合优度(goodness of fit)

|

|

均方误差(MSE)或均方根误差(RMSE)、残差分析、信息准则(AIC, BIC)、卡方检验(Chi-square test)、似然比检验等也常被用来分析回归算法的拟合优度。

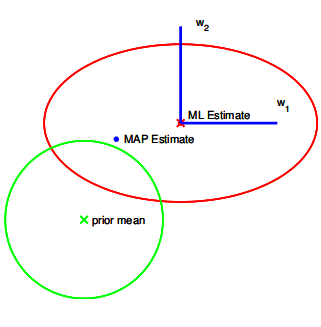

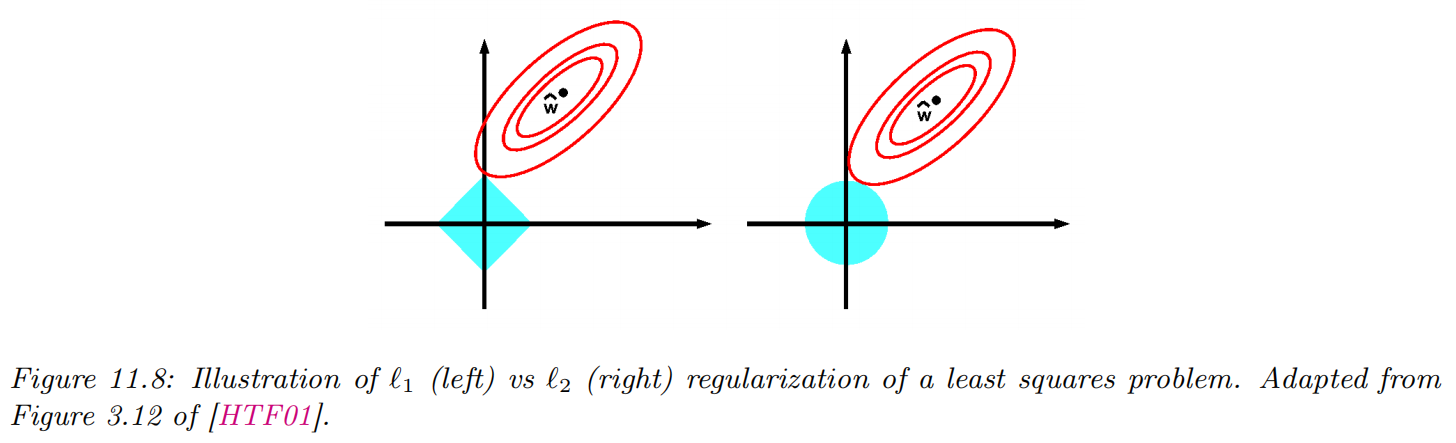

岭回归(Ridge)

其中

|

|

Lasso回归

|

|

弹性网络(Elastic net)

- 特点:结合L1和L2正则化

- 优点:克服Lasso和Ridge的局限性

- 适用场景:特征数大于样本数,或特征间高度相关

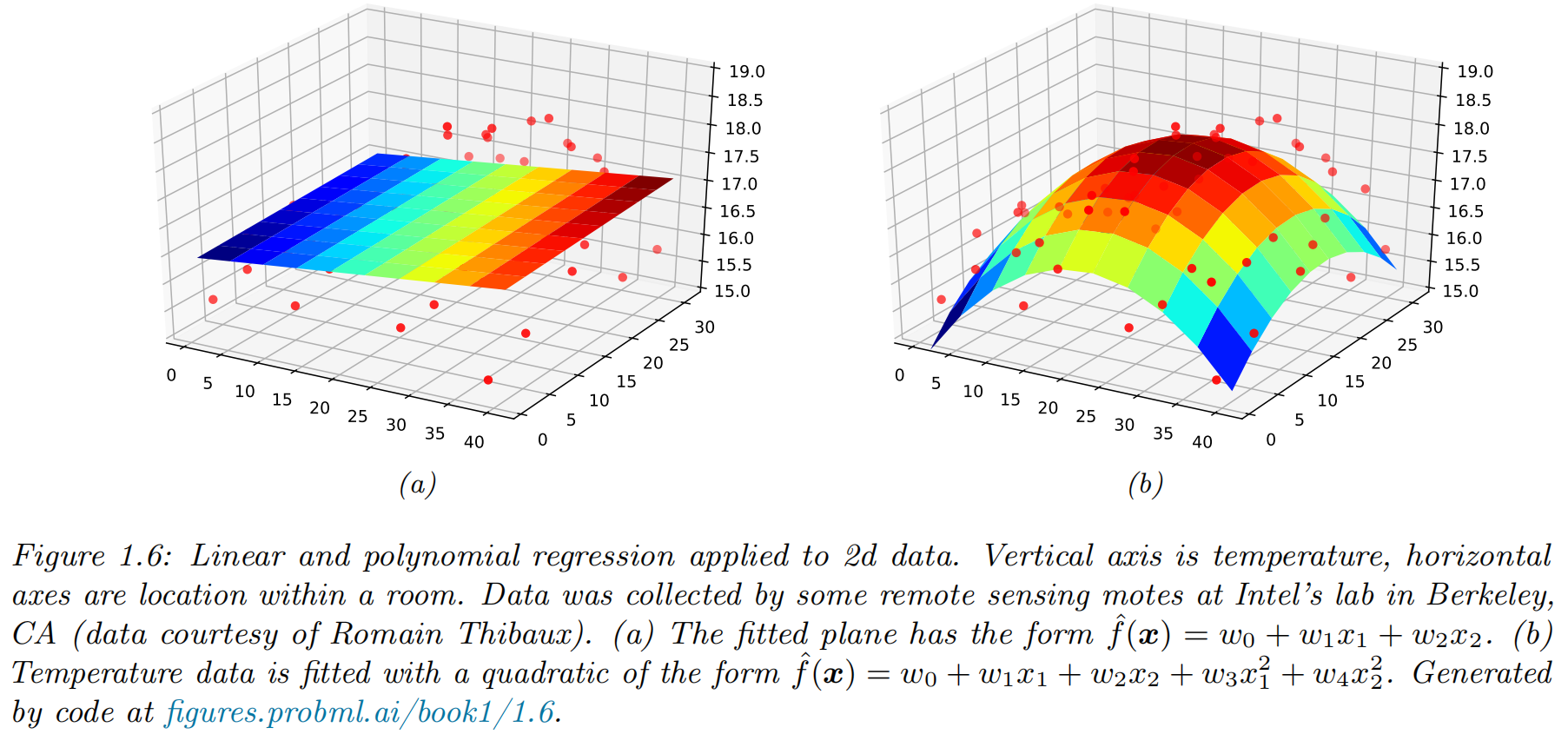

多项式回归(Polynomial regression)

- 模型:

|

|

样条回归:阶梯函数

|

|

样条回归:基函数

- 多项式和分段常数回归模型的一般化

- 基函数:应用于变量

- 模型

- 基函数的一些例子

- 多项式函数

- 分段常数函数

- 小波

- 傅里叶级数

- 样条

样条回归:分段多项式

-

在

-

例子:在点

-

自由度

-

使用更多的节点会导致更灵活的分段多项式

样条回归:约束和样条

|

|

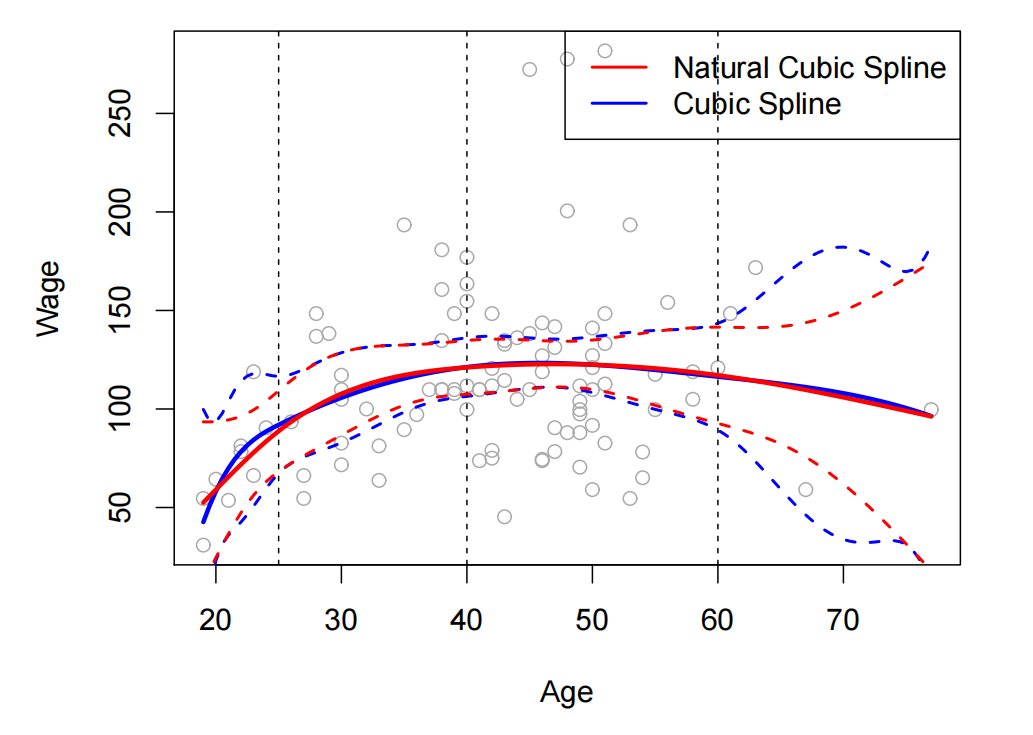

样条回归:样条基表示

- 回归样条(regression spline):

- 样条基

- 多项式基:

- 对每个节点的截断幂基

- 多项式基:

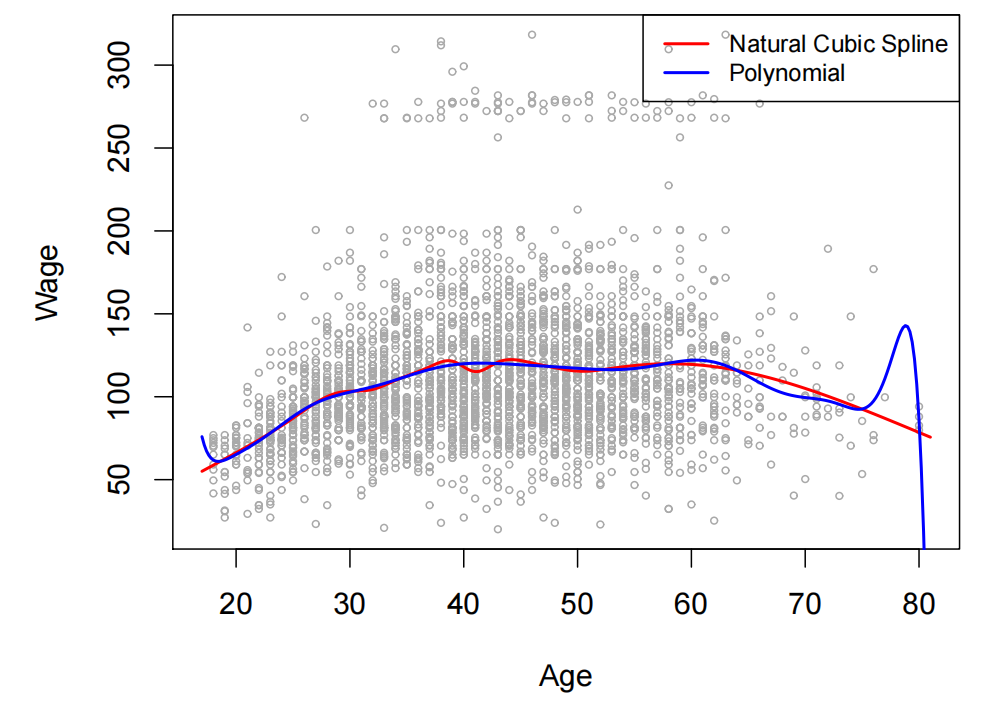

- 样条在预测变量的外部范围可能具有高方差

- 自然样条

- 具有额外边界约束的回归样条

- 要求函数在边界处为线性

- 自然样条通常在边界处产生更稳定的估计

与多项式回归的比较

|

|

平滑样条

|

|

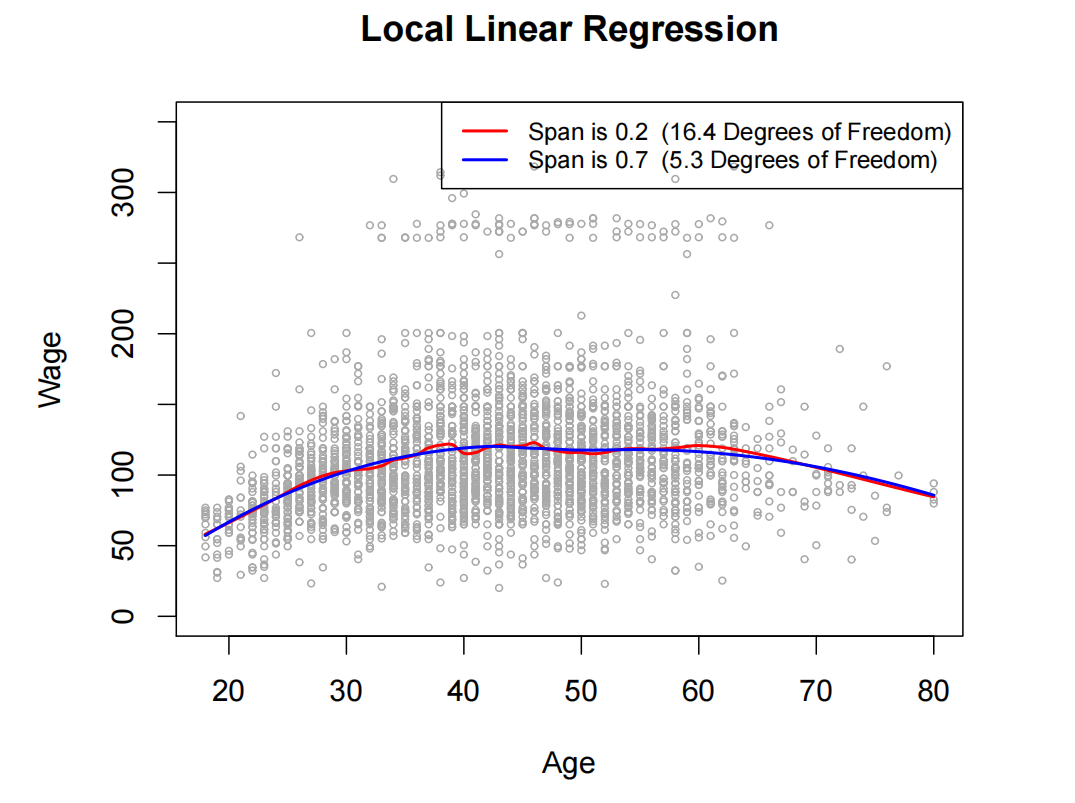

局部回归(Local regression)

|

仅使用附近的训练观测值来计算目标点

|

|

算法

|

局部线性回归

|

广义加性模型(GAM)

|

|

稳健线性回归(Robust linear regression)

|

|

偏最小二乘法(PLS)概述

- 定义:一种同时处理输入变量(X)和输出变量(Y)的统计建模和降维技术

- 核心思想:在X和Y之间构建潜在变量,最大化它们之间的协方差

- 主要用途:

- 高维数据的预测建模

- 处理多重共线性问题

- 同时分析多个响应变量

- 区别于PCA:PCA只关注X的方差,PLS同时关注X-Y关系

PLS工作原理

|

|

PLS与其他方法比较

|

PLS与PCA比较

|

与回归方法比较:

|

PLS在经济、管理、金融领域的应用

|

经济领域应用:

管理领域应用:

|

金融领域应用:

|

PLS优缺点与实施建议

|

优点:

缺点:

|

实施建议:

|

回归算法选择建议

|

|

分类(Classification)

|

|

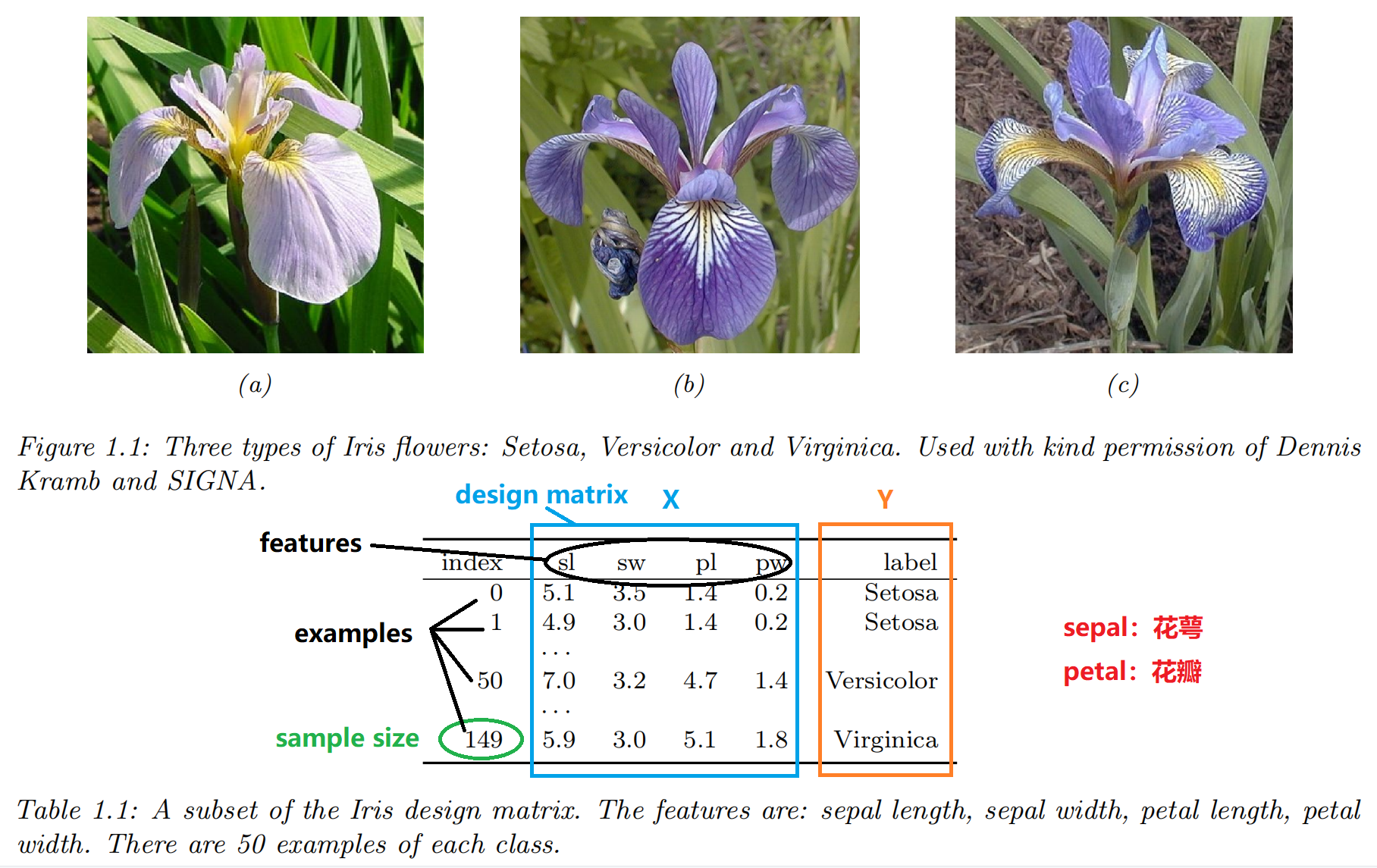

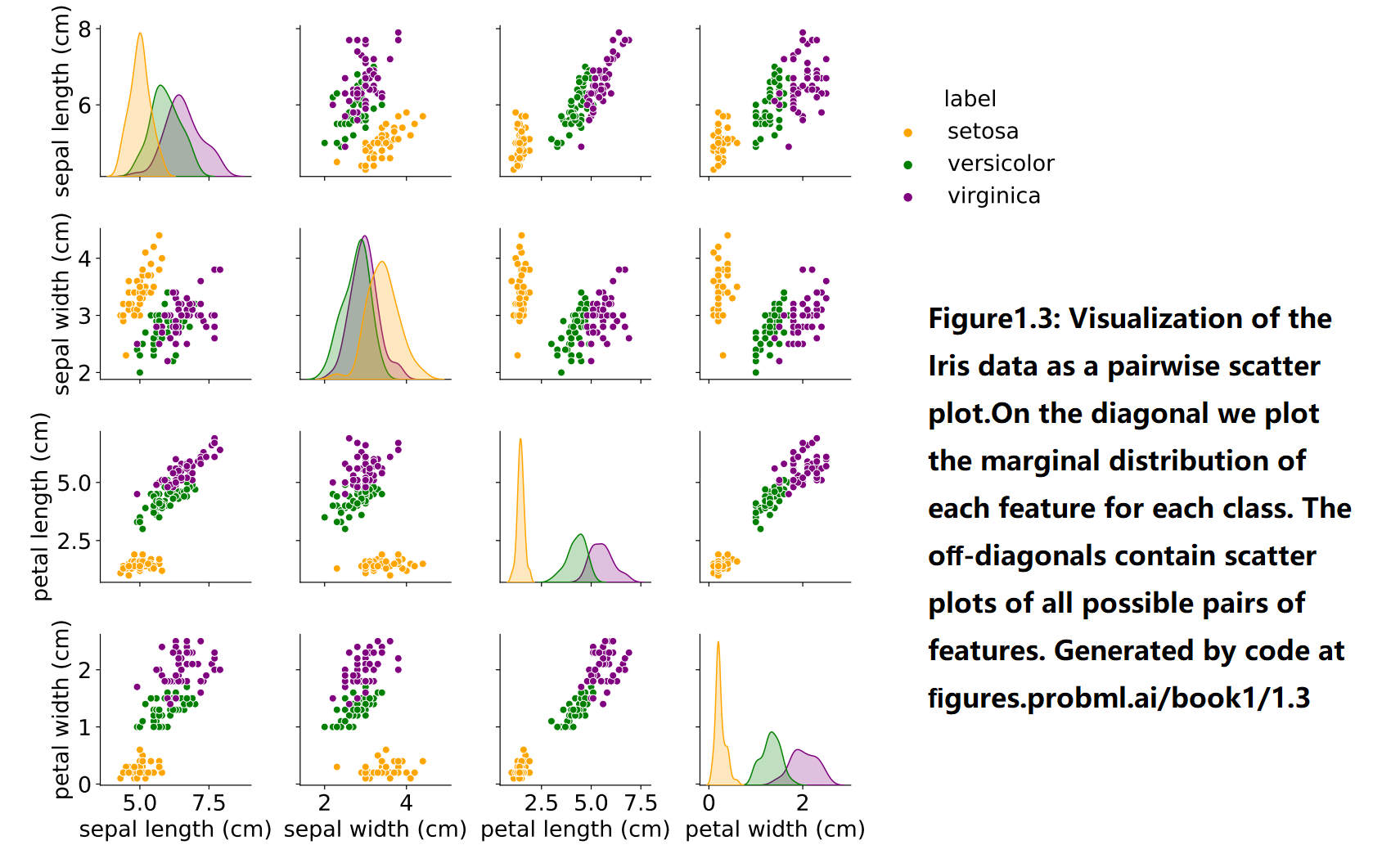

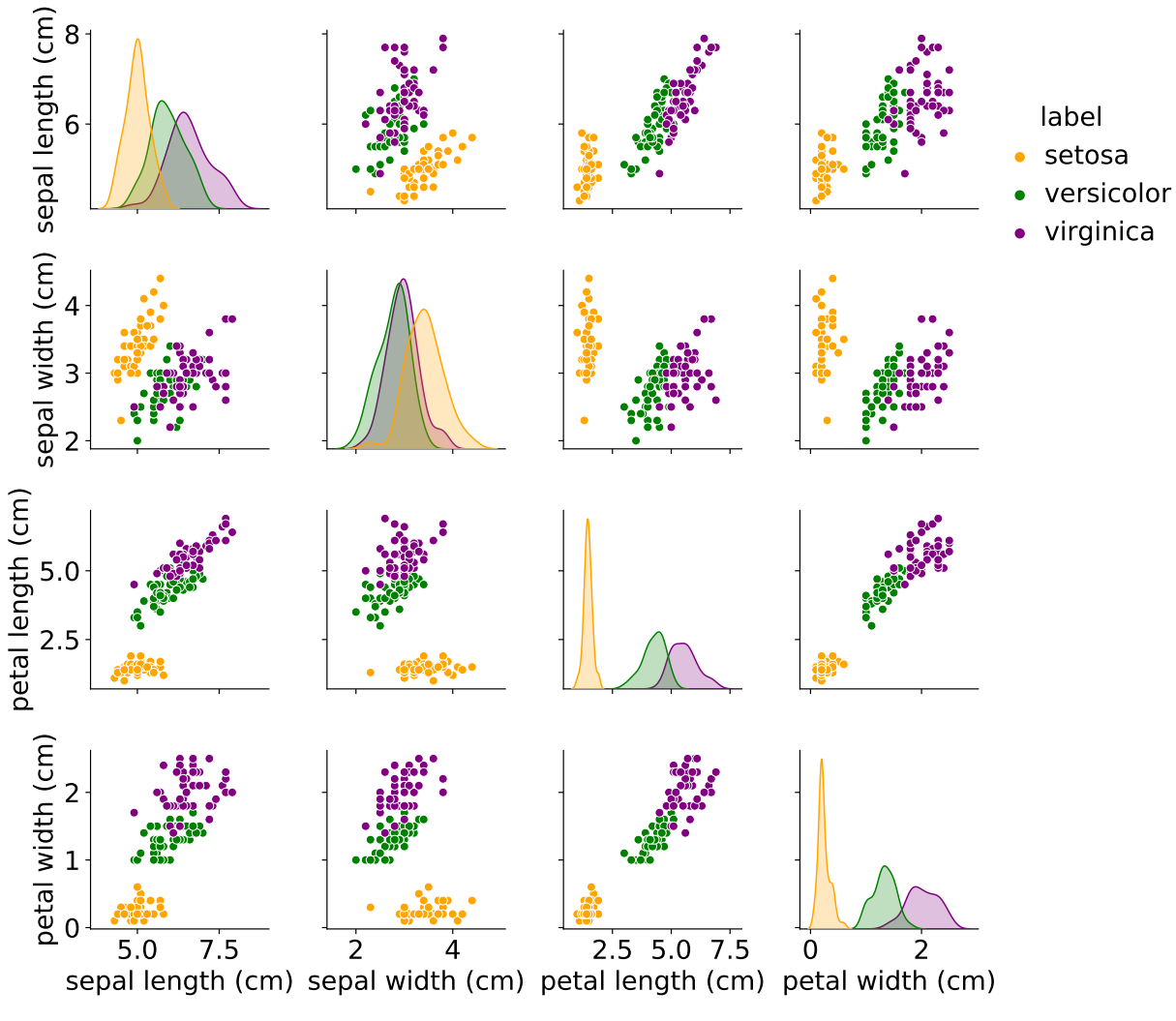

示例:对鸢尾花(Iris)进行分类

探索性数据分析

|

|

学习分类器

|

|

经验风险最小化(Empirical risk minimization)

- 训练集上的错误分类率(misclassification rate):

- 损失函数(loss function):

- 经验风险(empirical risk):训练集上预测器的平均损失

- 模型拟合(model fitting)/训练(training)通过经验风险最小化(empirical risk minimization)

不确定性(Uncertainty)

- 两种类型的不确定性

- 认知不确定性(epistemic uncertainty)或模型不确定性(model uncertainty):由于

缺乏输入输出映射的知识 - 任意不确定性(aleatoric uncertainty)或数据不确定性(data uncertainty):由于映射中的内在(不可约)随机性

- 认知不确定性(epistemic uncertainty)或模型不确定性(model uncertainty):由于

- 我们可以使用以下条件概率分布(conditional probability distribution) 来捕获不确定性:

极大似然估计(Maximum likelihood estimation)

-

似然函数(likelihood function):

-

对数似然函数(log likelihood function)

- 负对数似然函数(Negative Log Likelihood): 训练集的平均负

- 极大似然估计(the maximum likelihood estimate, MLE):

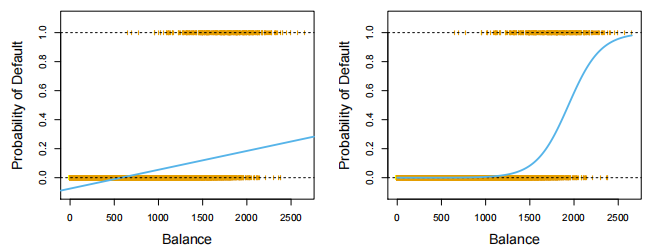

逻辑回归(Logistic regression)

|

source: ISLP |

估计与预测

|

|

多元逻辑回归(Multiple logistic regression)

|

|

预测

|

|

多项逻辑回归(Multinomial logistic regression)

-

对具有两个以上类别的响应变量进行分类

-

模型

- 对于

- 对于

- 对于

- 对数几率(对于

- 优点:

- 简单直观,计算效率高

- 可解释性强,易于理解和实现

- 直接提供概率输出

- 缺点:

- 只能表达线性决策边界

- 类别间有显著分离时参数估计不稳定

- 特征间相关性强时表现不佳

- 适用场景:

- 需要解释模型的场景

- 初步建模和基准模型

- 需要概率输出的应用

生成式分类模型

- 核心思想

- 在每个响应类别

- 使用贝叶斯定理将这些转换为

- 在每个响应类别

- 为什么我们需要生成式分类模型

- 当两个类别之间存在实质性的分离时,逻辑回归模型的参数估计非常的不稳定

- 如果预测变量

- 本节中的方法可以自然地扩展到多于两个响应类别的情况

- 假设定性响应变量

- 让

- 让

- 后验概率(贝叶斯定理)

- 估计

- 不直接计算后验概率

- 不直接计算后验概率

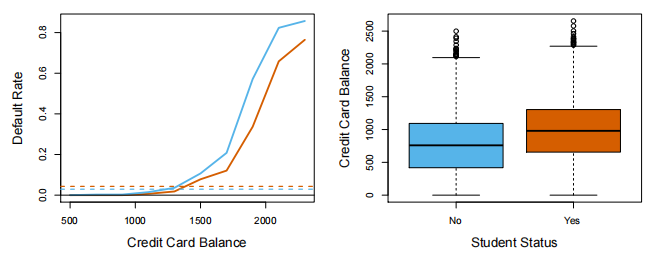

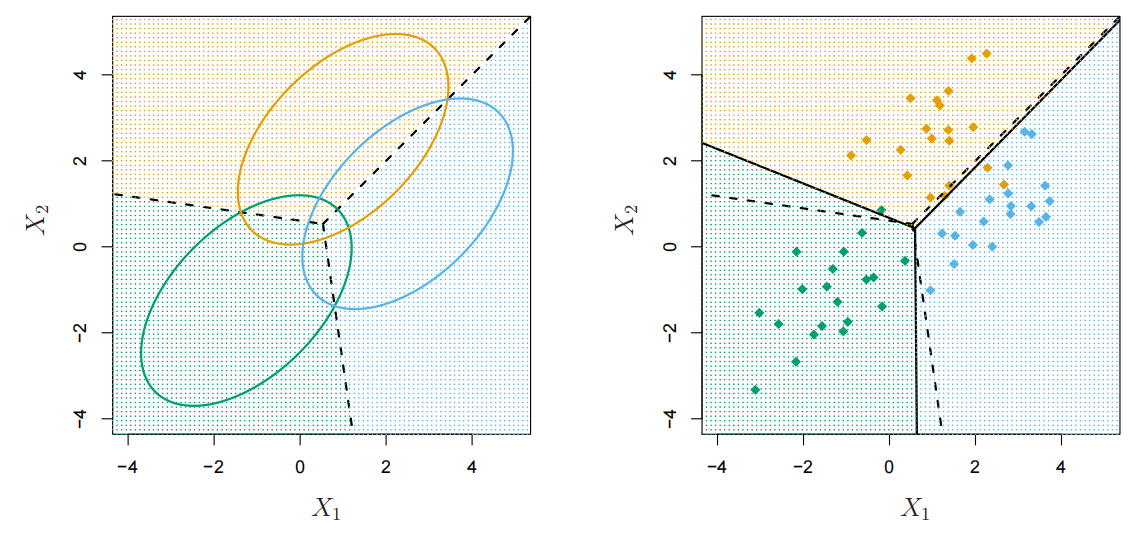

生成式分类模型:线性判别分析(LDA)(

|

|

例子

|

|

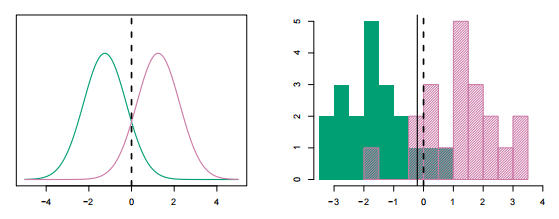

生成式分类模型:LDA(

- 多元高斯分布

|

|

|

|

- 优点:

- 样本量小时比逻辑回归更稳定

- 天然支持多类别问题

- 可进行降维

- 缺点:

- 假设数据服从高斯分布

- 假设所有类别共享同一协方差矩阵

- 只能生成线性决策边界

- 适用场景:

- 小样本多类别问题

- 类内方差相似的数据

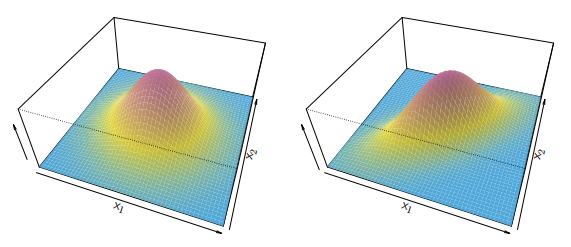

生成式分类模型:二次判别分析(QDA)

|

|

- 优点:

- 比LDA更灵活,可以拟合非线性决策边界

- 偏差小于LDA

- 每个类别有独立的协方差矩阵

- 缺点:

- 方差大于LDA,需要更多数据

- 计算复杂度高于LDA

- 易过拟合

- 适用场景:

- 中等规模数据集

- 类别间有明显不同方差的情况

生成式分类模型:朴素贝叶斯

- 假设:在第k类中,p个预测变量是独立的

- 后验概率

- 使用训练数据

- 如果

- 如果

- 为每个类别中第

- 核密度估计器

- 为每个类别中第

- 如果

- 如果

- 优点:

- 简单高效,训练速度快

- 特别适合高维数据

- 样本量较小时也能工作

- 缺点:

- 特征独立性假设通常不现实

- 对零频率问题敏感

- 适用场景:

- 文本分类、垃圾邮件过滤

- 高维稀疏数据

- 实时预测需求

广义加性模型(GAM)

|

将对数几率比建模为广义加性模型: |

|

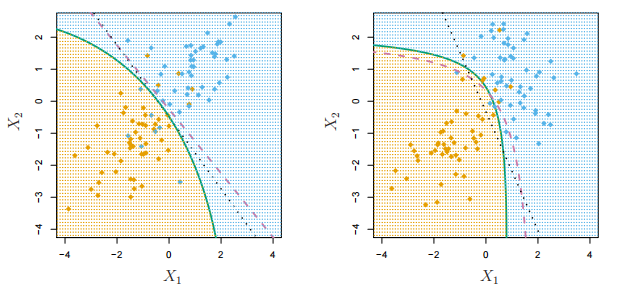

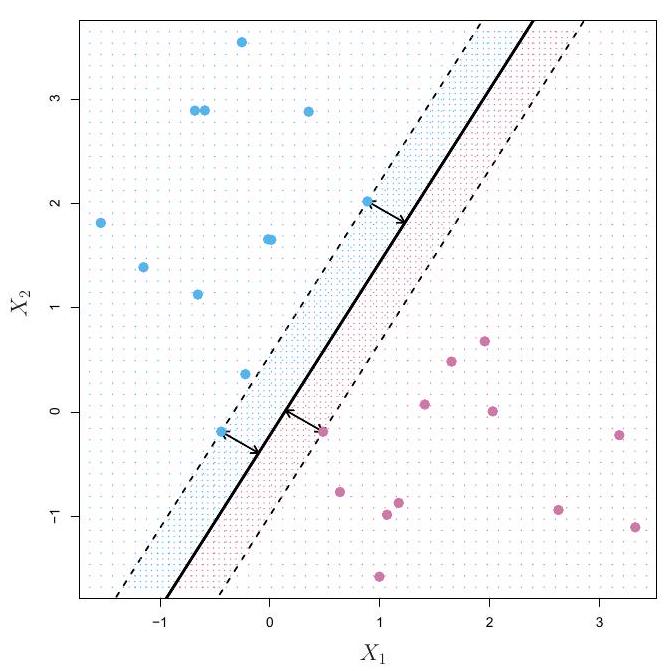

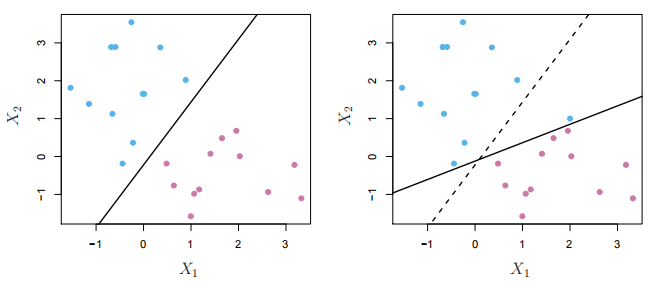

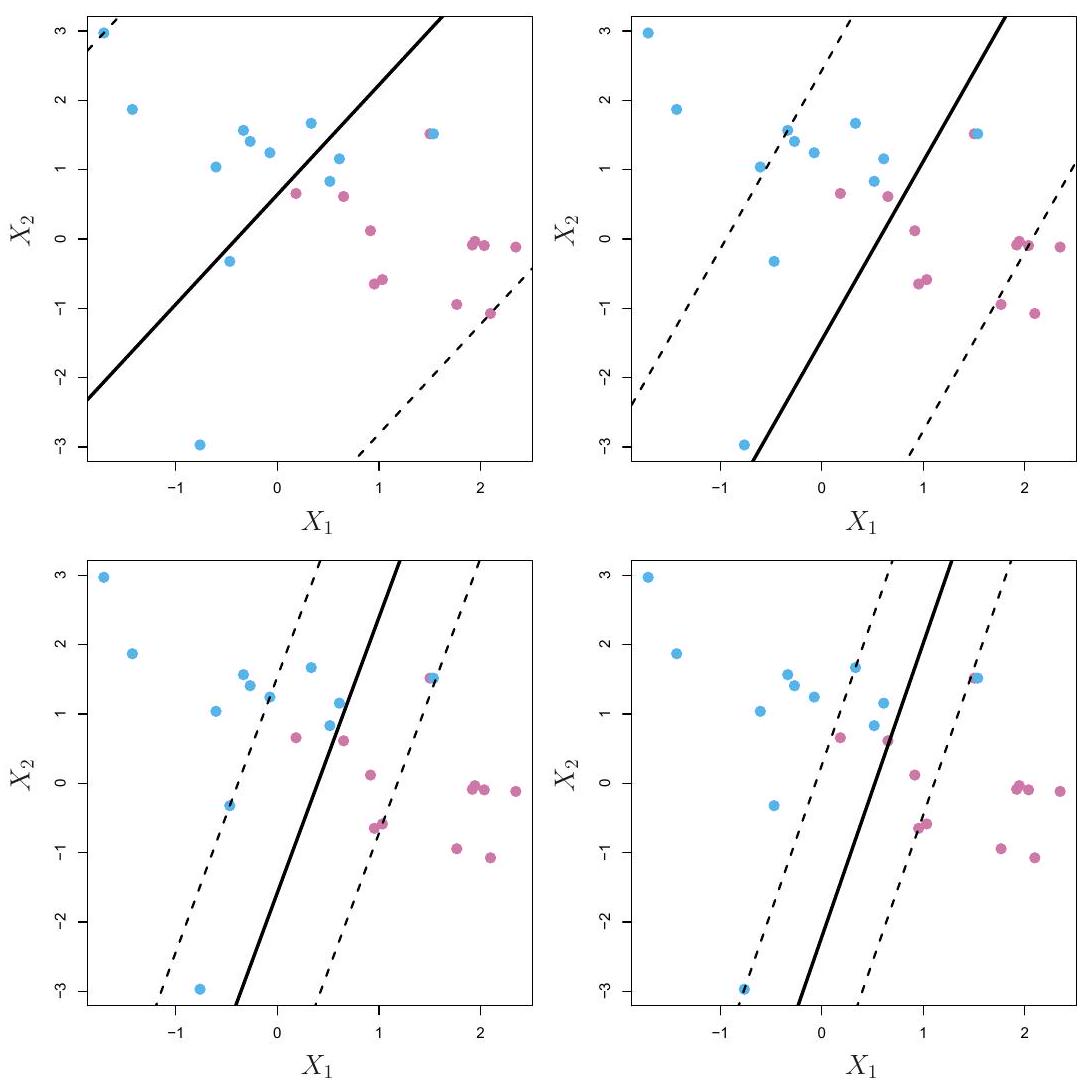

支持向量机:超平面

|

|

使用分离超平面进行分类

对于分离超平面

和

等价地,分离超平面具有以下性质

对所有

分离超平面

|

|

最大间隔分类器

|

|

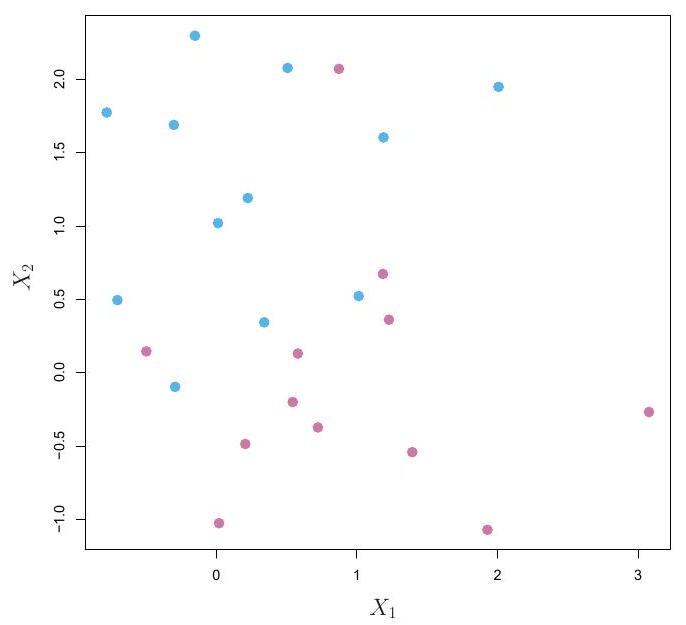

不可分离情况和噪声数据

|

|

|

|

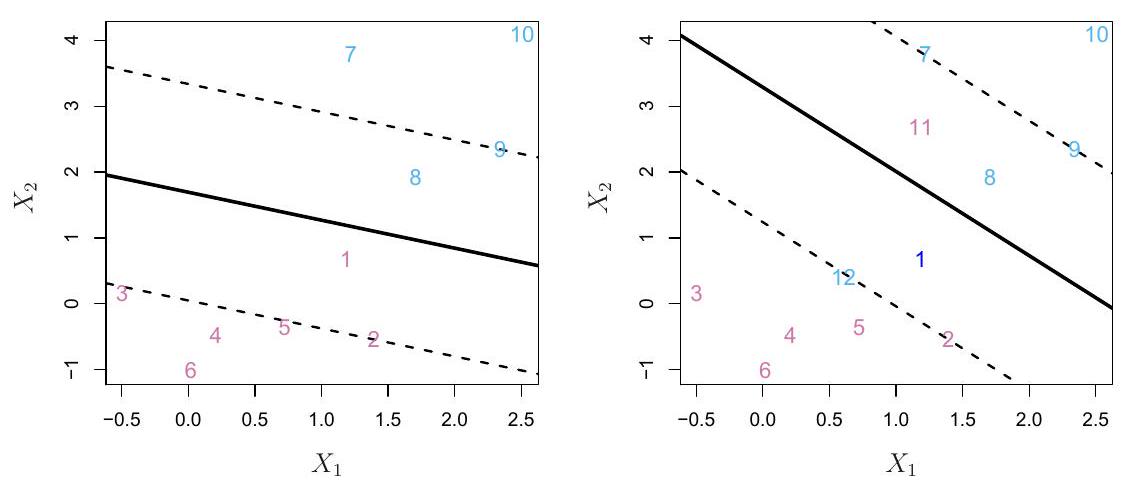

支持向量分类器(SVC)

|

|

参数

|

|

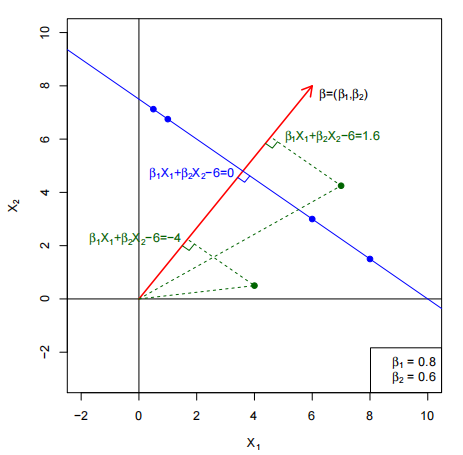

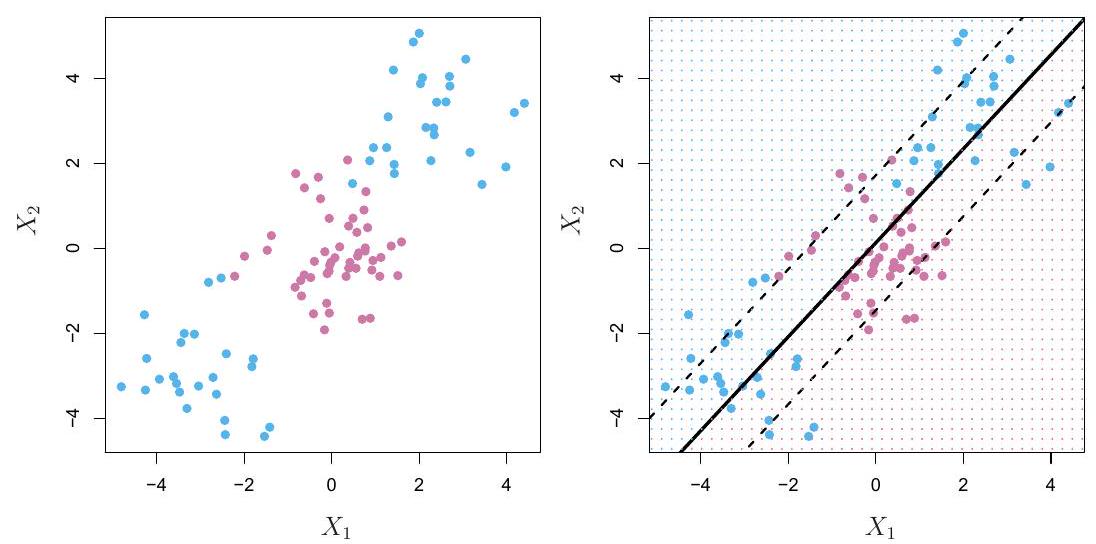

支持向量机(SVM)

支持向量机无法处理非线性。

我们能做什么?

利用多项式特征的非线性分类器

|

|

核函数

- 定义:

- 当且仅当对于任何数据

|

核函数的一些例子

|

假设

|

SVC vs. SVM

|

|

SVC

|

SVM

|

|

内积/核

|

|

|

|

函数形式

|

|

|

|

|

|

多类别SVM

-

一对一(OVO)分类

- 又称为全配对

- 为每对类别构建一个SVM

- 使用每个SVM对测试观测值进行分类

- 将观测值分配给最频繁分配的类别

-

一对多(OVA)分类

- 又称为一对剩余

- 为每个类别拟合

- 设

- 将观测值分配给

与逻辑回归的关系

-

支持向量分类器优化的铰链损失 + 惩罚形式:

- 设

- 优化模型

- 这与逻辑回归中的"损失"(负对数似然)非常相似。

- 设

-

SVM vs. 逻辑回归

- 当类别(几乎)可分离时,SVM比逻辑回归表现更好。LDA也是如此。

- 当不可分离时,逻辑回归(带岭惩罚)和SVM非常相似。

- 如果你希望估计概率,逻辑回归是首选。

- 对于非线性边界,核SVM很流行。也可以在逻辑回归和LDA中使用核,但计算成本更高。

- 优点:

- 在高维空间有效

- 通过核函数处理非线性关系

- 理论基础扎实

- 缺点:

- 不直接提供概率估计

- 参数调优困难

- 大数据集计算成本高

- 适用场景:

- 复杂决策边界

- 中小规模数据集

- 类别几乎可分的情况

分类算法选择建议

|

基于数据特征选择

|

基于应用需求选择

|

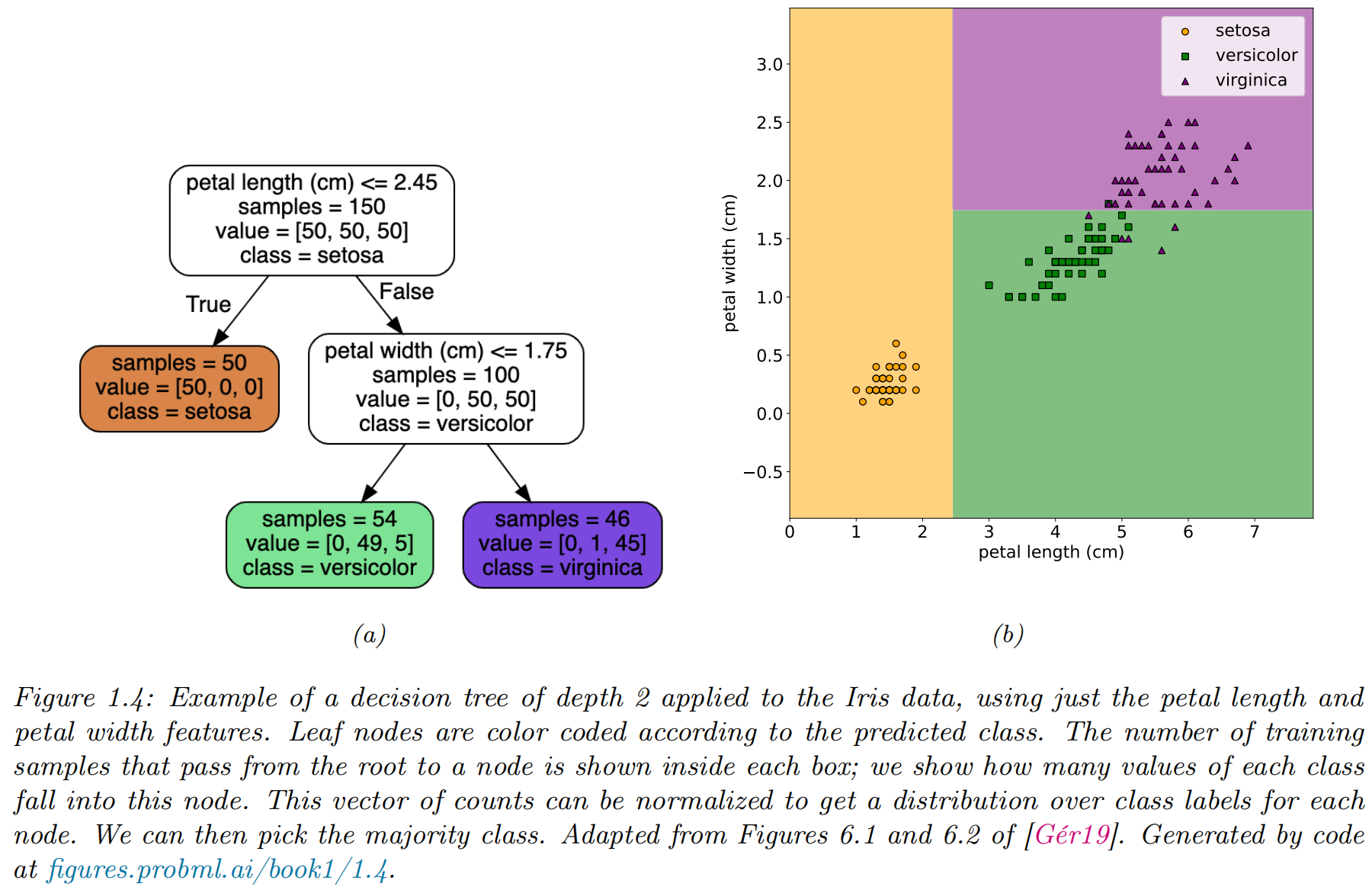

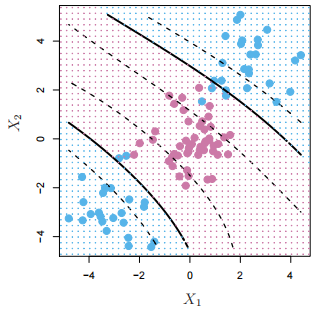

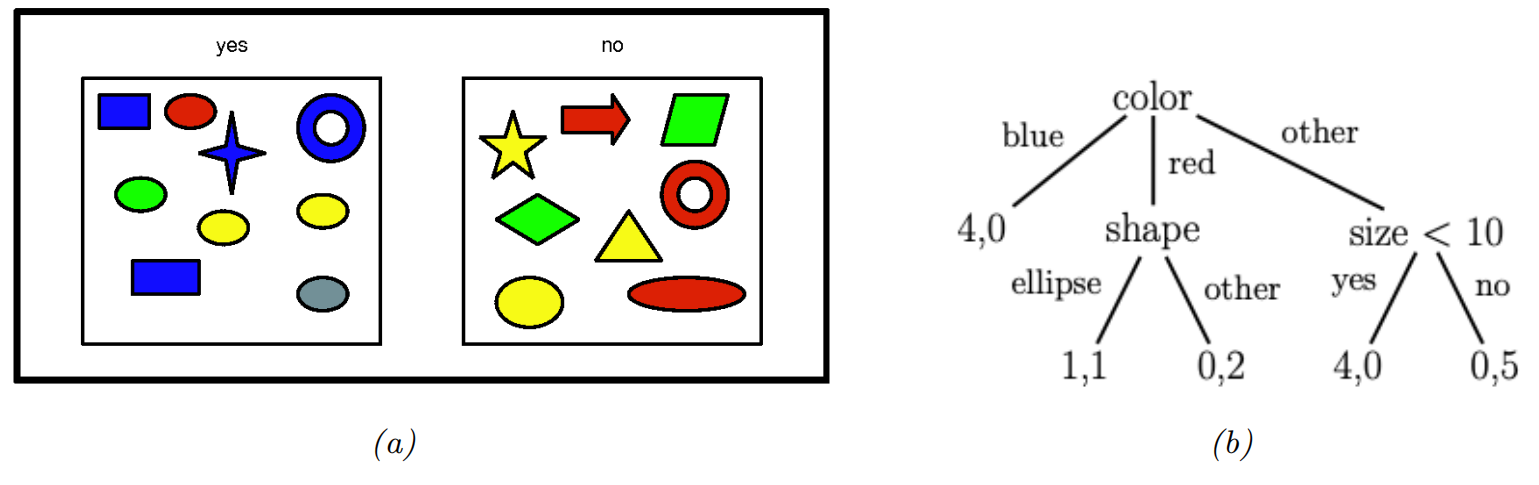

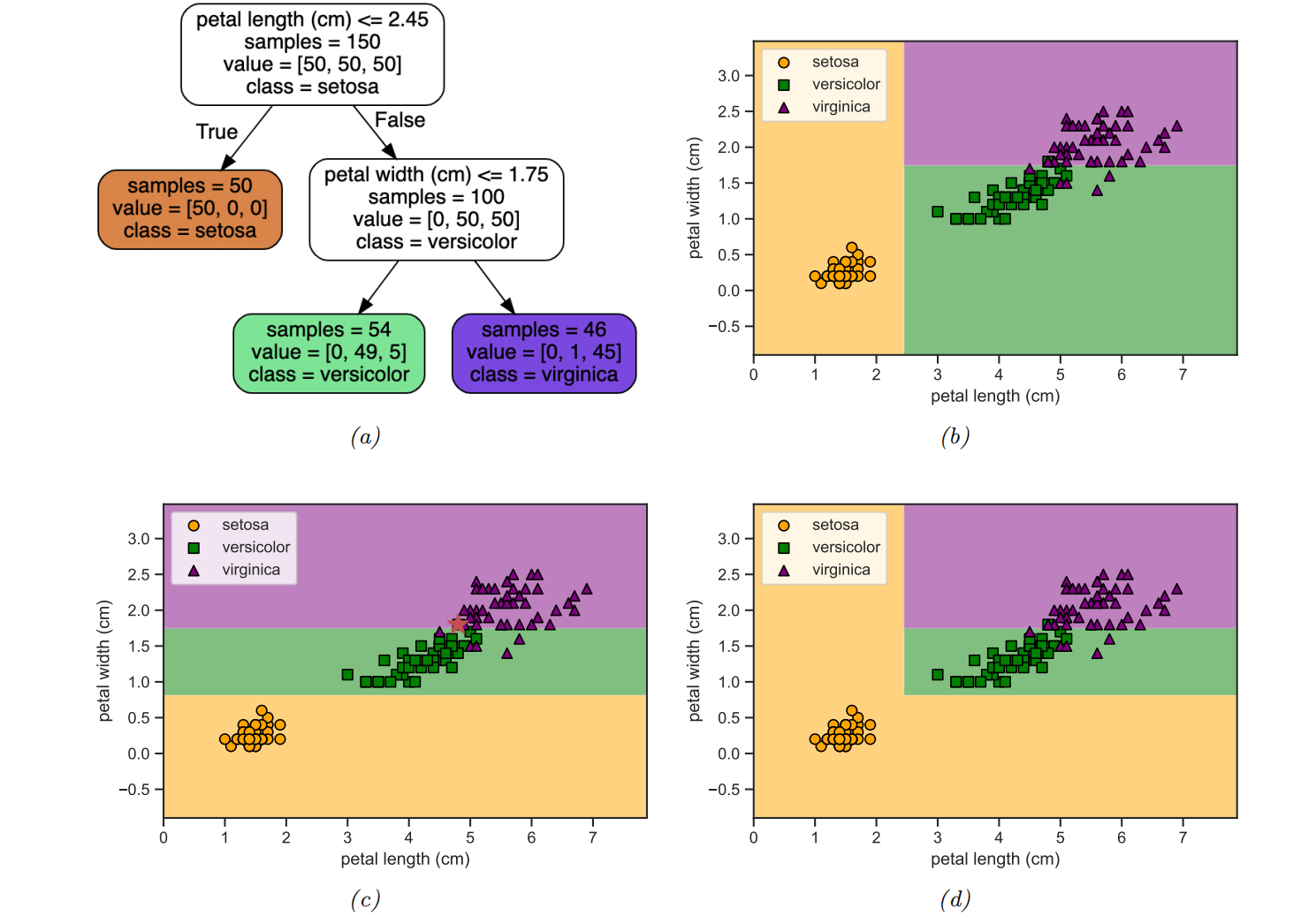

基于树的模型

|

|

模型定义

|

|

|

|

- 对于分类问题,叶节点包含类别标签的分布,而不仅仅是均值响应。

模型拟合

- 最小化以下损失:

- 它是不可微的

- 找到数据的最优分割是NP完全问题

- 标准做法是使用贪心过程,我们每次迭代地增加一个节点来生长树。

- 三个流行的实现: CART, C4.5, 和 ID3。

正则化

|

|

CART的优缺点

优点

|

缺点

|

集成学习

|

|

Stacking

-

Stacking (stacked generalization): 通过以下方式组合基础模型

- Stecking使用的组合权重需要在单独的数据集上训练,否则它们会将所有权重集中在表现最好的基础模型上。

-

举例:我们邀请不同专业背景的专家:

数学老师:根据数学练习表现预测:76分 心理咨询师:根据学习态度和压力管理预测:72分 历史老师:根据学生逻辑推理能力预测:74分最后,校长(元学习器)不直接评估学生,而是根据这三位专家的预测结果做出最终判断:

校长:分析三位专家预测,考虑每位专家在不同类型学生上的准确率 最终预测:75分

集成学习vs.贝叶斯模型平均(BMA)

- 集成考虑形式为以下的更大假设类

- BMA使用

- 关键区别

- 在BMA的情况下,权重

- 在无限数据的极限情况下,只会选择一个模型(即MAP模型)

- 集成权重

- 在BMA的情况下,权重

Bagging

- bagging("bootstrap aggregating")

- 是一种简单的集成学习形式,将

- 鼓励不同的模型做出多样化的预测

- 数据集是有放回抽样的(bootstrap sampling)

- 一个给定的样本可能出现多次,直到我们每个模型有共计

- 是一种简单的集成学习形式,将

- 举例:想象有5位老师,每位老师都使用相同的判断方法,但只能看到班上随机80%的学生的历史成绩和学习情况(有放回抽样):

老师A:基于自己看到的80%学生数据预测:平均75分 老师B:基于不同的80%学生数据预测:平均73分 老师C:基于不同的80%学生数据预测:平均78分 ... 最终预测:所有老师预测分数的平均值 = 75分

-

Bootstrap的缺点

- 每个基础模型平均只“看到了”63%的唯一输入样本。

- 没有被特定基础模型使用的37%的训练实例被称为袋外实例(out-of-bag,oob)。

- 我们可以使用基础模型在这些oob实例上的预测性能作为测试集性能的估计。

- 这提供了交叉验证的有用替代方案。

-

Bootstrap的主要优点是它防止集成过度依赖任何单个训练样本,从而增强鲁棒性和泛化能力。

-

Bagging并不总是能提高性能。特别是,它依赖于基础模型是不稳定的估计器(决策树),这样忽略一些数据就会显著改变得到的模型拟合结果。

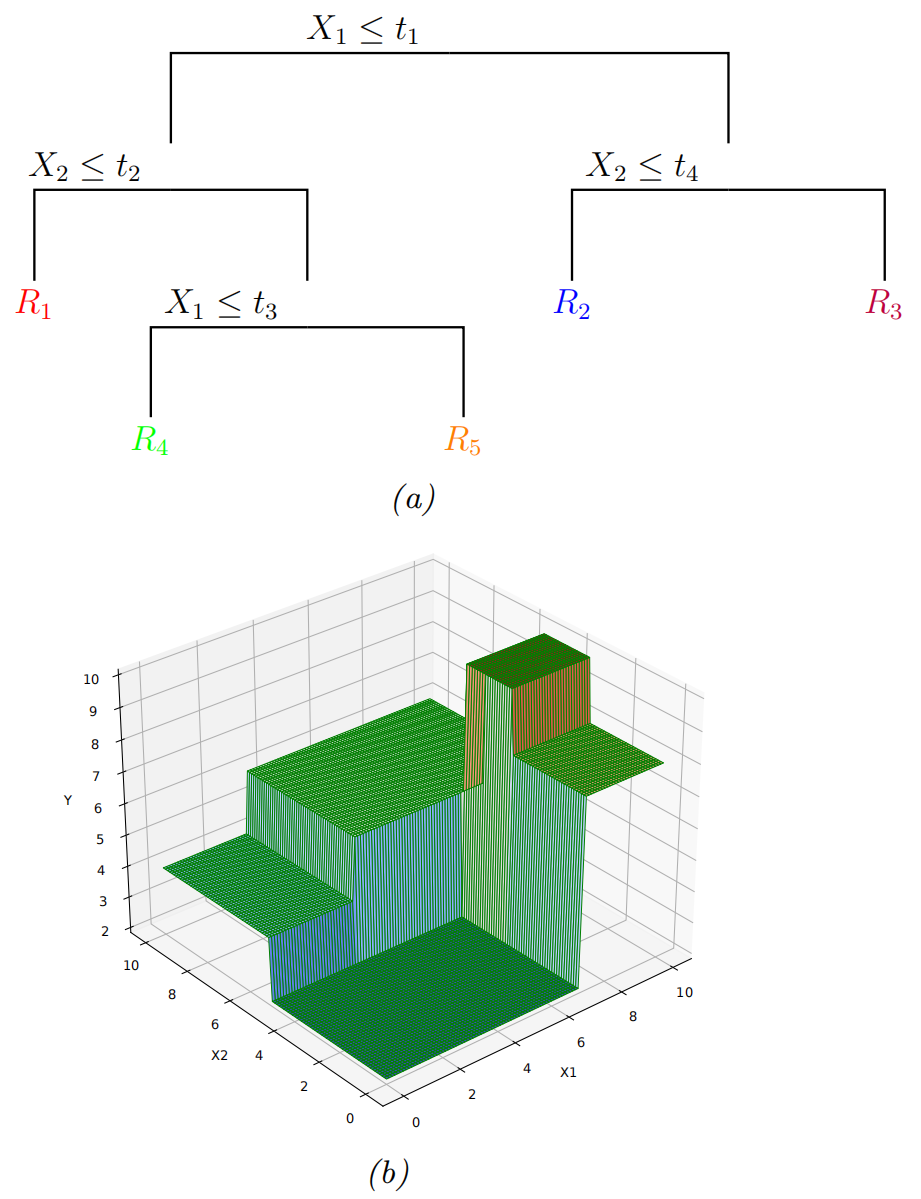

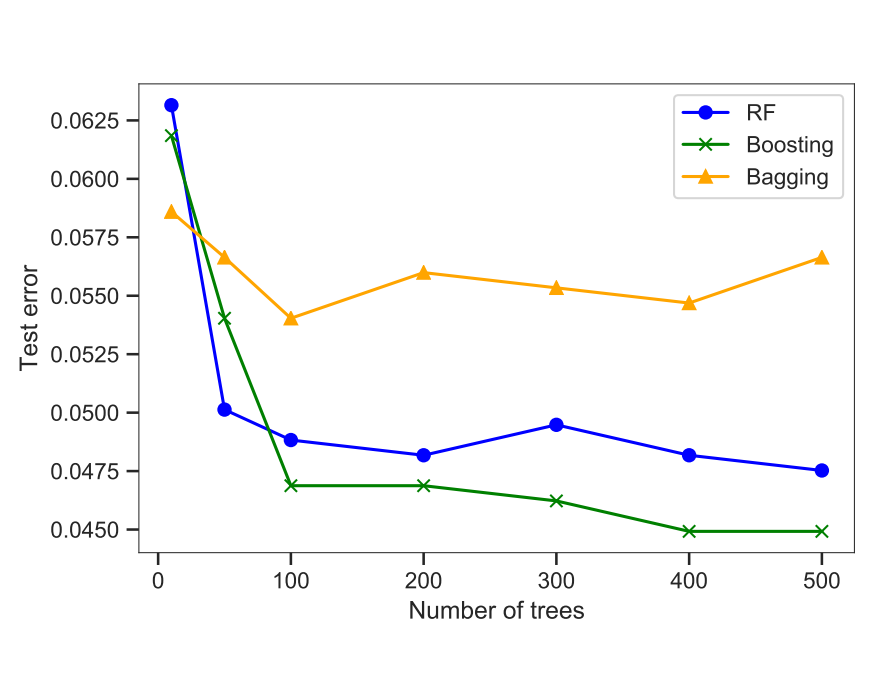

随机森林(Random forests)

|

|

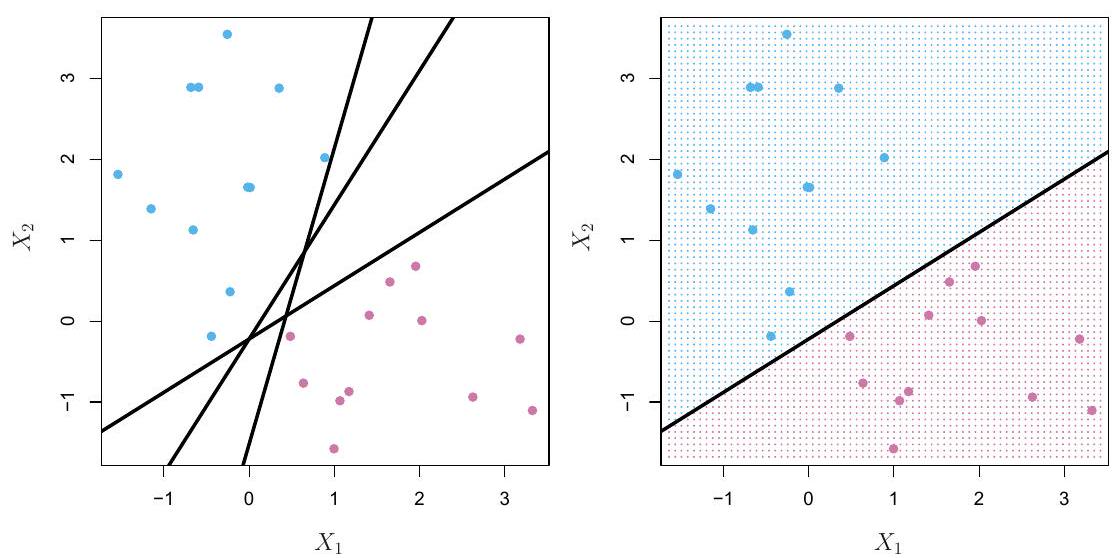

提升法(Boosting)

|

|

-

提升法是一种顺序拟合加法模型的算法,其中每个

- 首先在原始数据上拟合

- 根据

- 在这个加权数据集上拟合

- 不断重复这个过程,直到我们拟合了所需数量

- 首先在原始数据上拟合

-

只要每个

- 如果

- 我们可以通过上述程序提升其性能,使最终的

- 如果

-

提升法、装袋法和随机森林

- 提升法通过拟合相互依赖的树来减少强学习器的偏差

- 装袋法和随机森林通过拟合独立的树来减少方差

- 在许多情况下,提升法可以表现得更好

提升算法的优缺点

|

|

基于树的学习算法选择建议

基于数据规模

基于问题复杂度

基于可解释性需求

|

基于数据质量

基于计算资源

特征特性考虑

|

无监督学习(Unsupervised Learning)

|

|

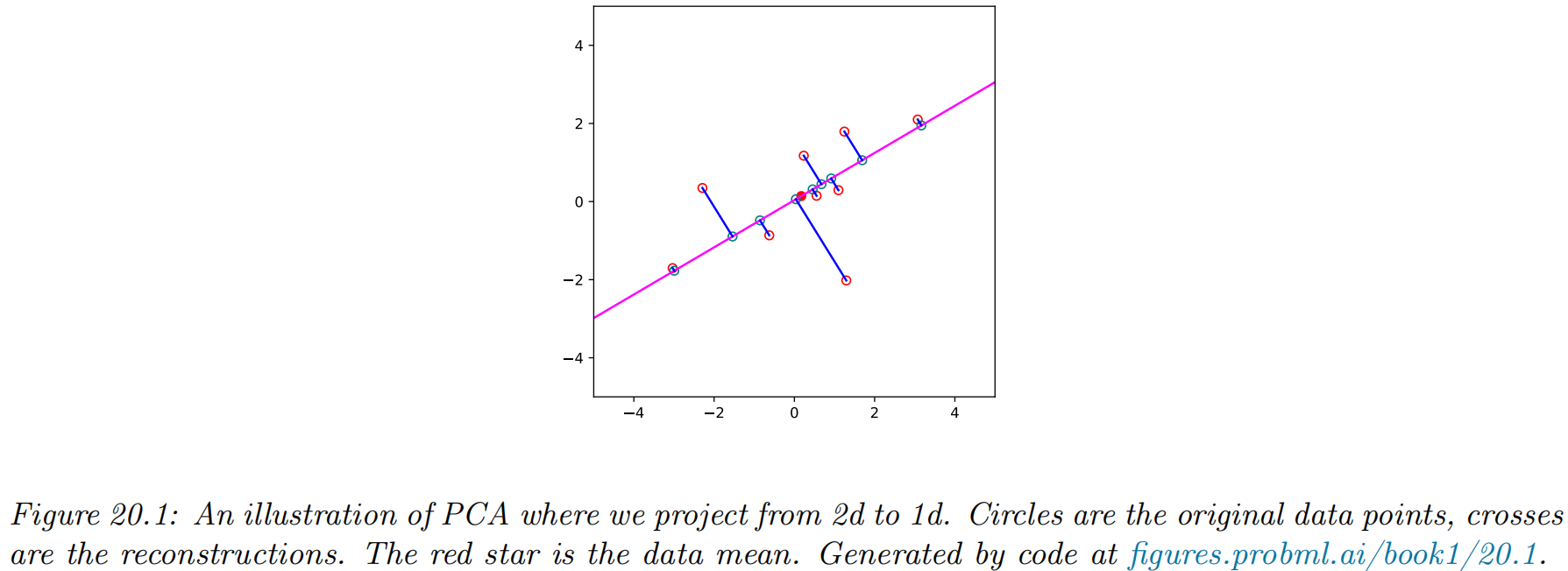

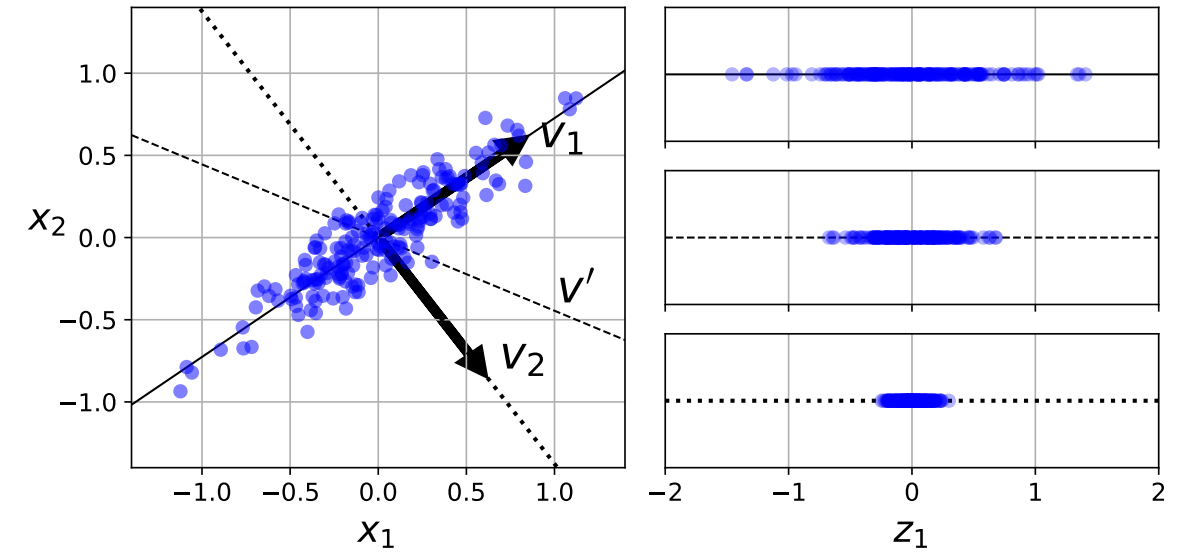

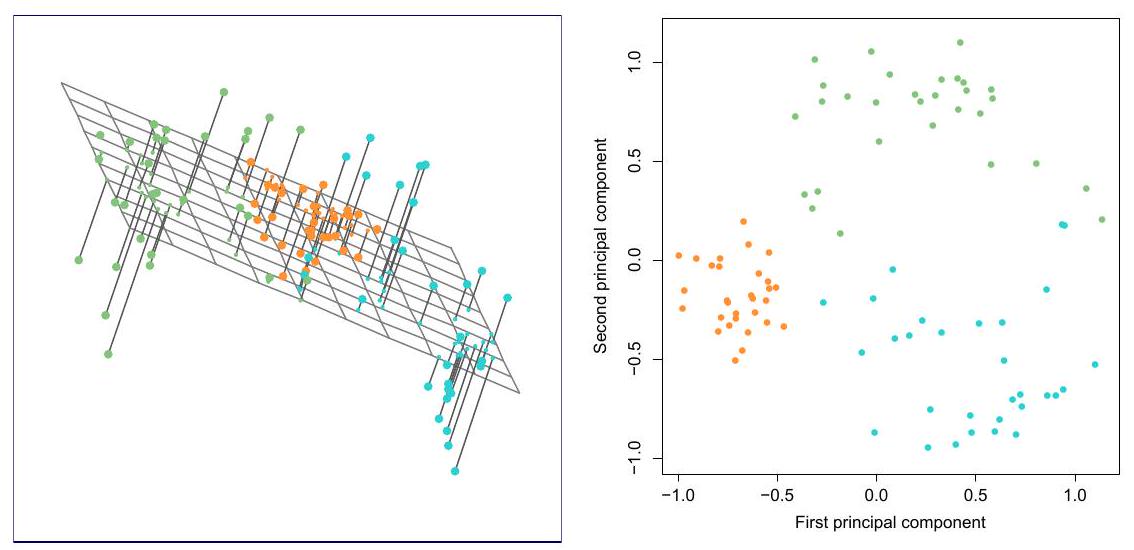

降维算法:主成分分析(PCA)

|

|

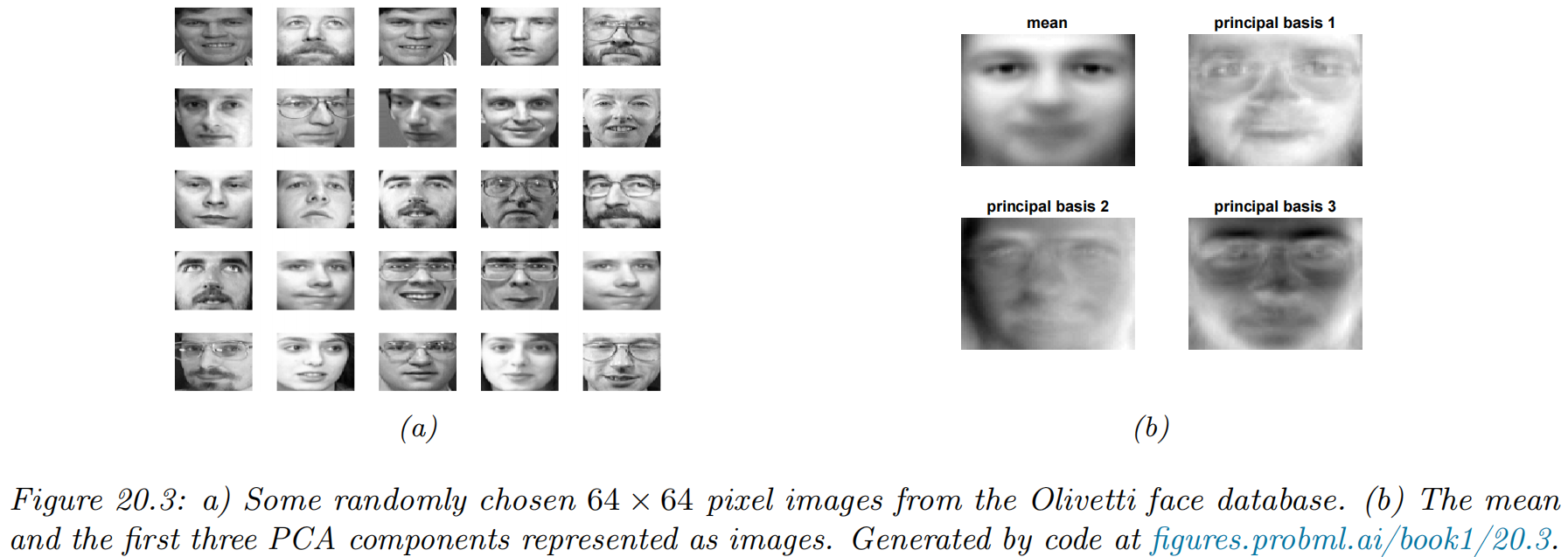

样本在低维线性子空间的投影示例

- 2d

- 人脸识别(64*64d

详细示例

|

|

主成分的另一种解释:最接近观测值的低维超平面

|

|

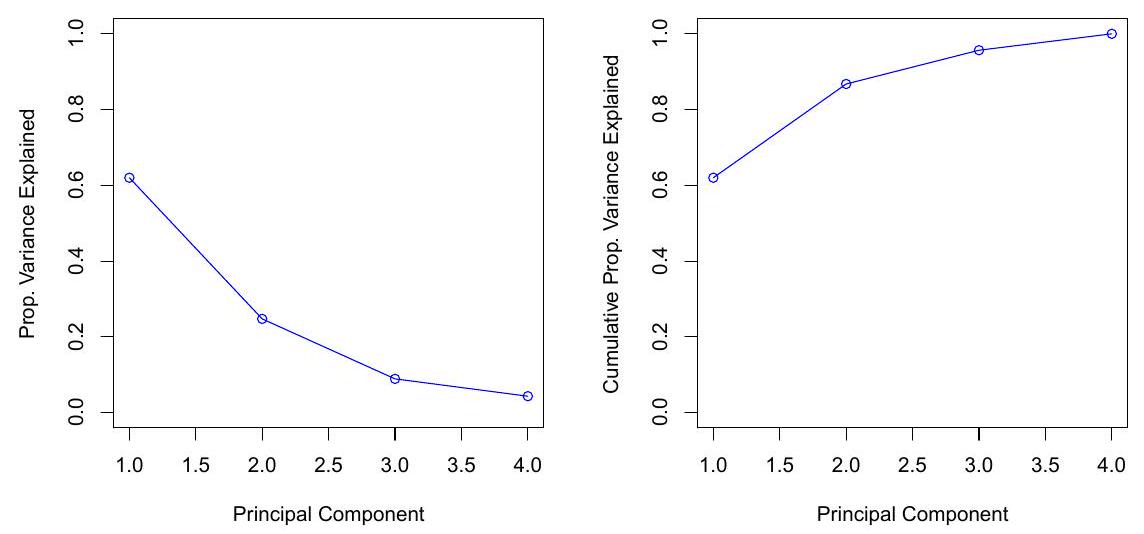

解释方差比例(PVE)

-

数据集中存在的总方差定义为

-

第

-

第

-

数据的方差可以分解为前

数 据 的 方 差 前 个 主 成 分 的 方 差 维 近 似 的 均 方 误 差 -

我们可以将PVE解释为由前

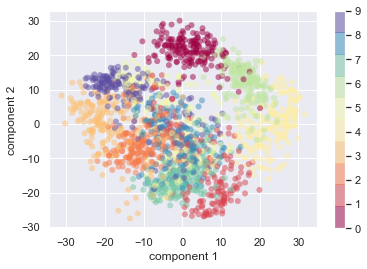

编程:可视化

|

|

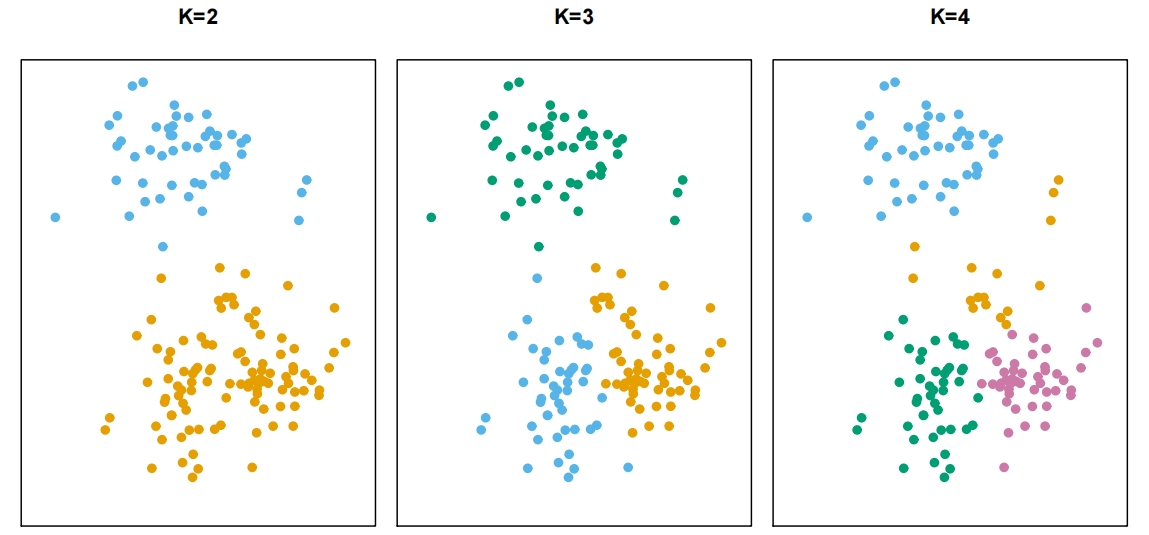

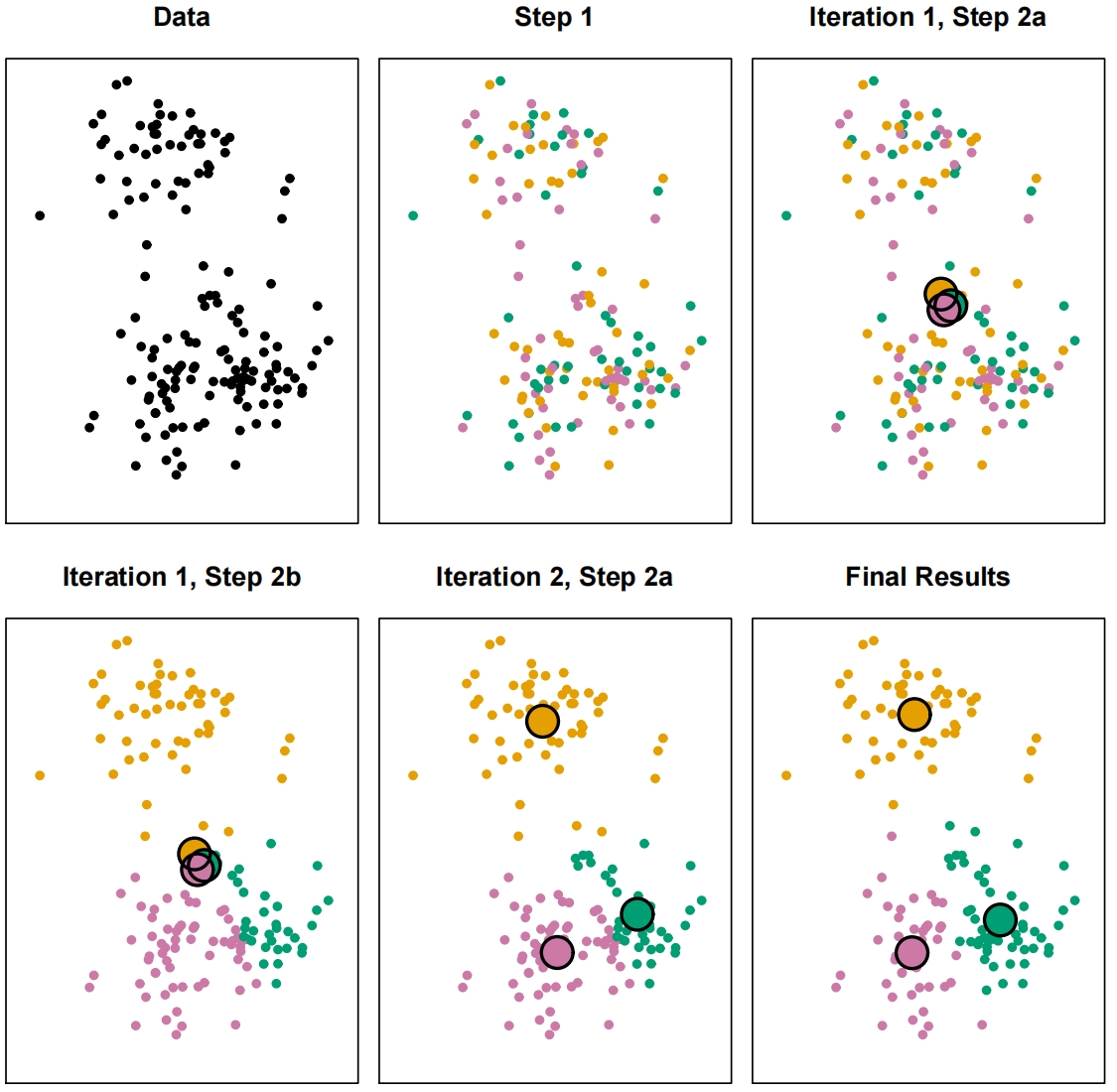

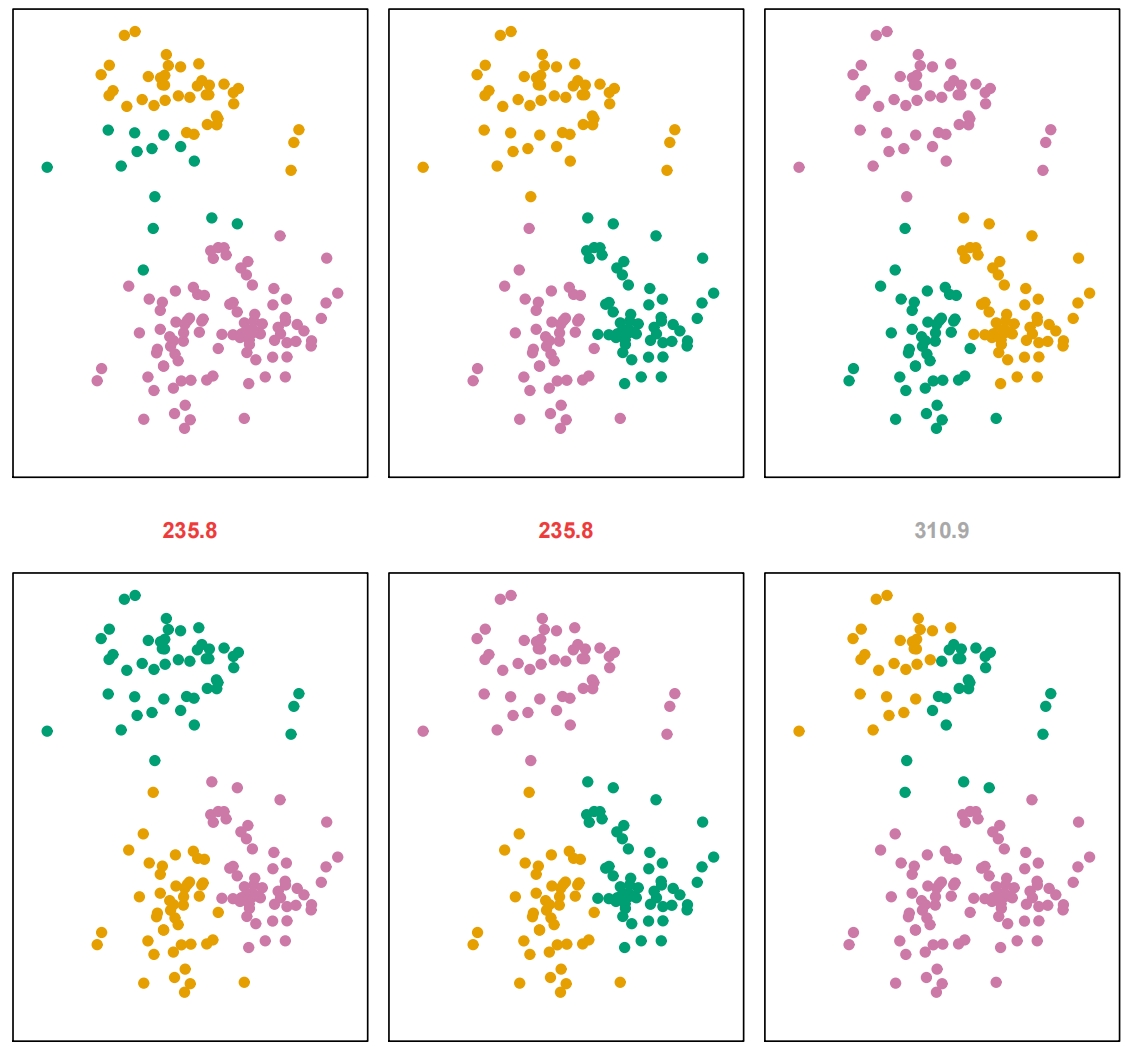

聚类算法:K-Means聚类

- 将数据集划分为K个不同的、不重叠的聚类。

- 令

-

-

- 对所有

- 对所有

-

- 核心思想

- 使聚类内变异尽可能小

- 聚类内变异

|

|

主成分回归(PCR):基本概念

- PCR是结合 主成分分析(PCA) 与标准回归的技术

- 两阶段方法:

- 第一阶段:使用PCA降维

- 第二阶段:对选定的主成分进行回归

- 解决多重共线性和高维数据问题

- 特别适用于处理大量相关预测变量的情况

主成分回归(PCR):数学原理与实现步骤

|

步骤一:标准化

步骤二:PCA转换

步骤三:主成分回归

|

|

主成分回归(PCR): 优缺点

|

|

主成分回归(PCR):与其他方法比较

| 方法 | 方法特点 | 是否考虑Y进行转换? | 最佳应用场景 |

|---|---|---|---|

| PCR | 使用PCA后回归 | 否 | 多个相关预测变量 |

| PLS | 创建与Y相关的成分 | 是 | 当Y应引导降维时 |

| 岭回归 | 收缩所有系数 | 否 | 当所有预测变量都应保留 |

| Lasso | 将部分系数收缩至零 | 否 | 需要特征选择时 |

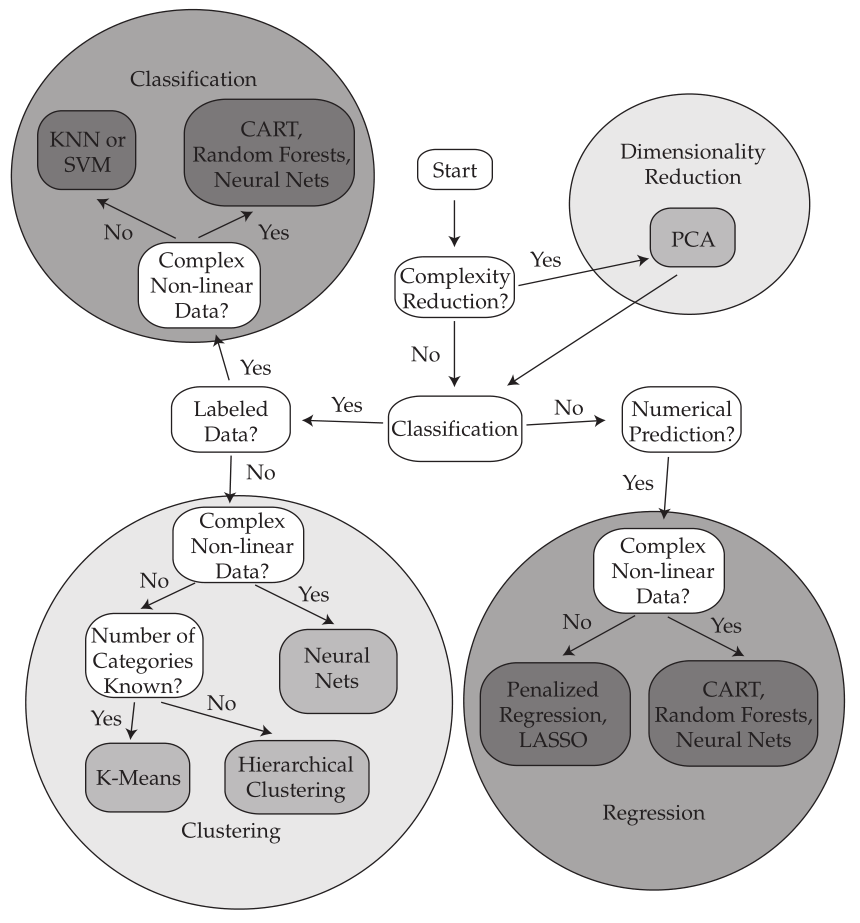

机器学习算法选择

|

|